Увеличение числа рейсов гражданской авиации в последнее

время обуславливает актуальность задачи повышения ситуационной осведомлённости

экипажа на сложных этапах полёта, таких как взлёт, посадка, руление.

Перспективным средством помощи экипажу является система улучшенного видения,

отображающая вид закабинной обстановки на первичном индикаторе пилота. Кадр

системы улучшенного видения формируется инфракрасным или многоспектральным

датчиком, производящим обзор передней полусферы в положительном направлении

строительной оси самолёта, и обеспечивающим возможность обнаружения препятствий

в условиях ограниченной видимости и в ночное время. Другой системой повышения

ситуационной осведомлённости экипажа является индикатор на лобовом стекле

(ИЛС), представляющий проекцию пилотажно-навигационной информации на фоне

закабинной обстановки.

Вместе с тем простое отображение дополнительной информации,

даже представленной в удобном виде, не решает задачу снижения информационной

нагрузки на пилота, что обусловливает важность и актуальность задачи

интеллектуальной обработки полётной информации и её эффективного представления

пилоту. Традиционно ИЛС предназначался для вывода цифро-шкальной информации.

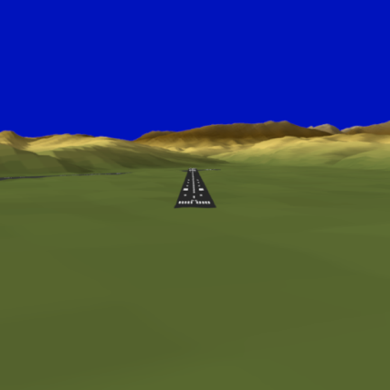

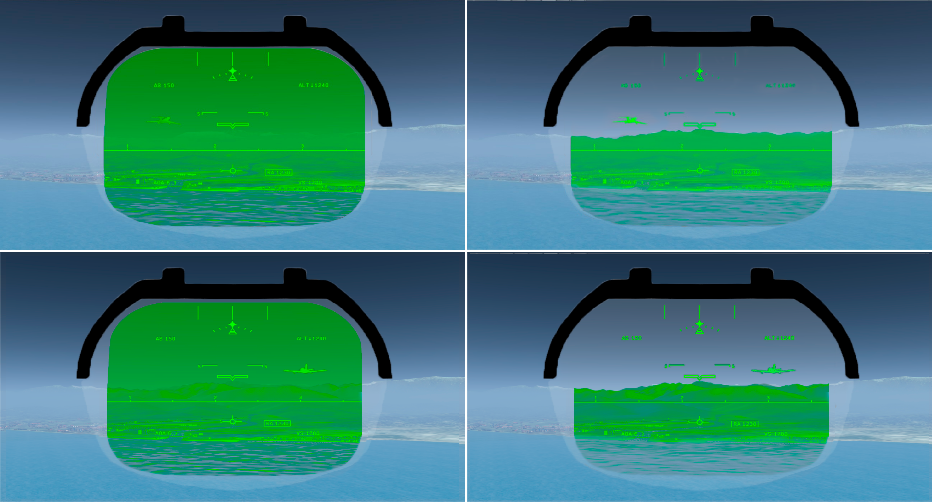

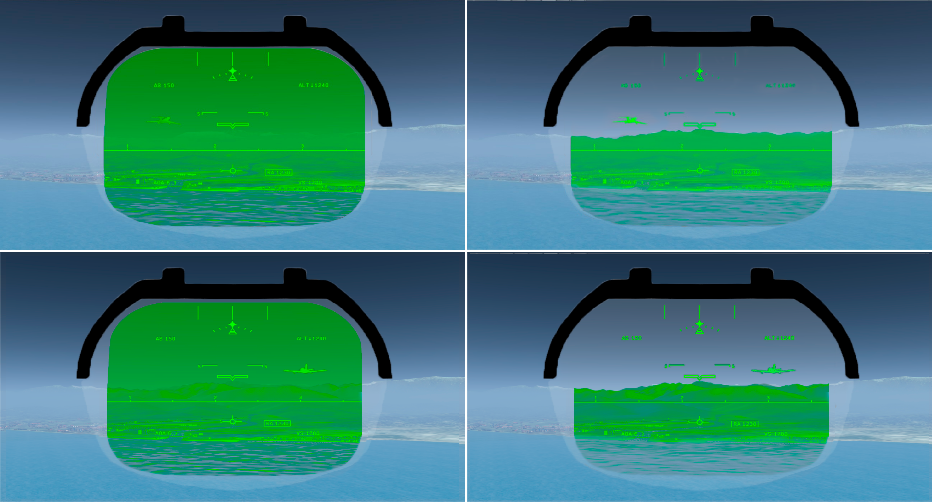

Однако в настоящее время многие самолёты также оснащены системами улучшенного

видения (Рисунок 1). Вывод видеопоследовательности на ИЛС вызывает трудности

поскольку большие яркие области, могут скрывать от пилота закабинную

обстановку, а динамические препятствия (самолёты, пересекающие траекторию

движения, и транспортные средства на ВПП) могут быть малозаметны.

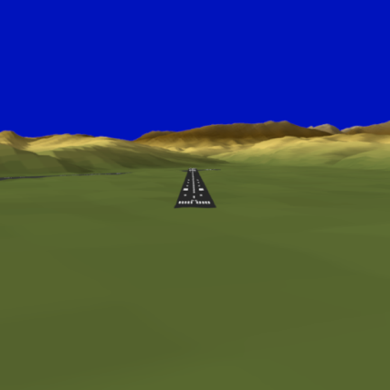

Рисунок 1: Системы помощи экипажу современных

воздушных судов: (слева) Система синтезированного видения, (в центре) Система

улучшенного видения, (справа) Индикатор на лобовом стекле с кадром системы

синтезированного видения.

Это обусловливает необходимость предварительной обработки

видеоинформации от датчика системы улучшенного видения для снижения яркости

малоинформативных объектов и повышения яркости динамических препятствий.

Подобная обработка позволит снизить время, необходимое для обнаружения

препятствия, и повысить ситуационную осведомлённость экипажа. В течение

последнего десятилетия методы машинного обучения достигли значительного

прогресса в таких задачах машинного зрения, как обнаружение препятствий и

повышение качества изображения. Это обусловлено как появлением вычислителей,

поддерживающих массово-параллельные вычисления, с одной стороны, так и

развитием методов на основе глубоких свёрточных нейронных сетей, с другой.

Основные полученные результаты. В работе предложен

алгоритм обнаружения препятствий на взлётно-посадочной полосе на основе

глубокой свёрточной нейронной сети ObstacleGAN. Рассматривается задача

фильтрации данных, поступающих от датчика инфракрасного диапазона, для

эффективного представления на индикаторе на лобовом стекле. Для создания

алгоритма решены следующие подзадачи:

- определены технические требования к алгоритму

обработки кадров улучшенного видения;

- разработана структурная схема алгоритма;

- разработана архитектура глубокой свёрточной

нейронной сети ObstacleGAN;

- архитектура сети реализована в виде сценария

для библиотеки PyTorch;

- подготовлена обширная выборка для обучения и

тестирования алгоритма;

- произведено обучение предложенной сети на

графическом процессоре;

- выполнено математическое моделирование работы

алгоритма;

- проведены экспериментальные исследования для

подтверждения работоспособности алгоритмов и оценки их качества.

Тестирование работы алгоритма производилось на видеопоследовательностях,

моделирующих различные этапы полёта: взлёт, заход на посадку, руление – с

использованием истинной разметки областей динамических препятствий. Алгоритм

продемонстрировал высокую точность обнаружения препятствий. Значение

коэффициента Жаккара составило 0,88 для дневных последовательностей и 0,75 для

ночных последовательностей, что подтвердило работоспособность сети ObstacleGAN.

Разработанный алгоритм был реализован в виде прикладного ПО

для тестирования и оценки качества работы. Произведено качественное и

количественное тестирование алгоритма при моделировании захода на посадку в

условиях ограниченной видимости. Тестирование показало, что использование

разработанного алгоритма снижает время обнаружения препятствий на ВПП на 10–15

секунд и позволяет пилоту раньше увидеть ориентиры аэродрома.

Актуальность. Актуальность работы обусловлена

повышением интенсивности воздушного движения. В связи с повышением числа

рейсов, большое число летательных аппаратов находится одновременно в зоне

аэродрома. Это повышает сложность управления воздушным судном на таких сложных этапов

полёта как взлёт, посадка и руление. Это обуславливает актуальность разработки

систем, повышающих ситуационную осведомлённость экипажа и снижающих

операционную нагрузку на пилота.

Возможность технической реализации проекта.

Разработанный алгоритм производит параллельную обработку данных и может быть

реализован на платформе современной интегрированной модульной авионики.

Вычислительная сложность алгоритма позволяет реализовать его для обработки

кадров системы улучшенного видения с разрешением 640×480 пикселей, с

использованием 3 процессоров с тактовой частотой 1,8 ГГц и одного

малогабаритного графического процессора.

Алгоритм был реализован в виде прикладного ПО для операционной

системы Windows для тестирования и оценки качества работы.

Рассматриваемый подход основывается на гипотезе о том, что

комплексирование данных систем улучшенного и синтезированного видения позволяет

увеличить контрастность кадра системы улучшенного видения при отображении на

ИЛС. Такое комплексирование применяется в системе комбинированного видения [1,

2, 3, 4] (CVS). Система комбинированного видения производит смешивание значений

интенсивности кадров систем синтезированного и улучшенного видения для

включения в состав виртуальной сцены динамических препятствий, наблюдаемых

инфракрасным датчиком.

Обзор современной литературы показал, что до настоящего

времени не проводилось исследований алгоритмов комплексирования кадров систем

синтезированного и улучшенного видения, обеспечивающих фильтрацию кадра датчика

инфракрасного диапазона для эффективного отображения на ИЛС. В данной работе

рассматривается разработка алгоритма комплексирования данных систем

синтезированного и улучшенного видения, основанное на оценке оптического

потока. Система улучшенного видения оснащена датчиком дальнего инфракрасного

диапазона (8–14 мкм). Результат комплексирования должен обеспечивать высокую

контрастность и подчеркивать динамические препятствия (например, самолёт,

транспортное средство на взлётно-посадочной полосе). Разработанный алгоритм

основывается на предположениях, высказанных в предыдущих исследованиях [5, 6].

Постановка задачи. Рассматривается задача фильтрации

данных, поступающих от датчика инфракрасного диапазона, для эффективного

представления на индикаторе на лобовом стекле.

Дан комплекс программного обеспечения, моделирующего

бортовые системы синтезированного (ССВ) и улучшенного видения (СУВ), трёхмерная

модель рельефа и объектового состава аэропорта Сочи. Требуется разработать

алгоритм, производящий снижение яркости малоинформативных областей и повышение

яркости динамических препятствий.

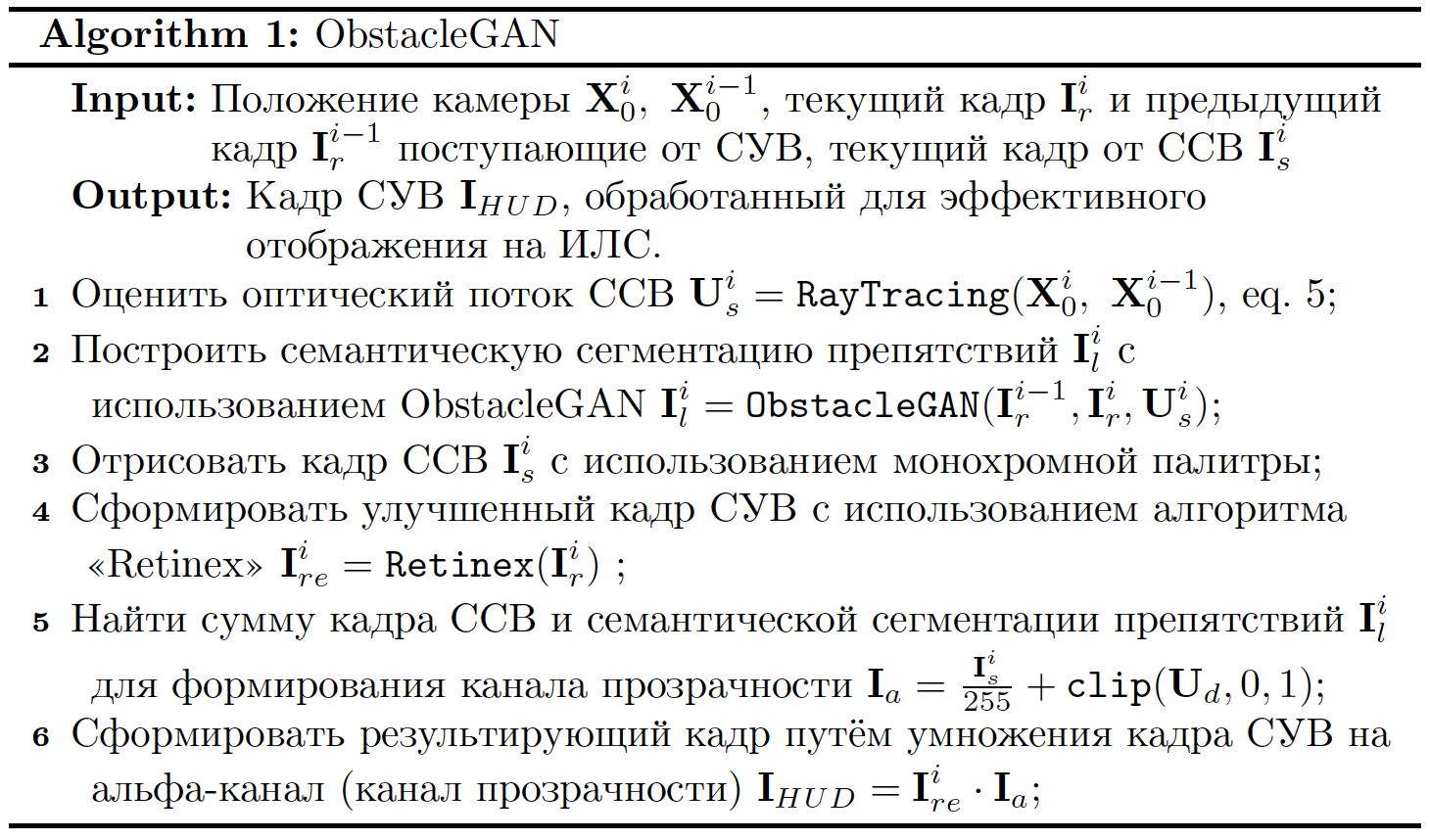

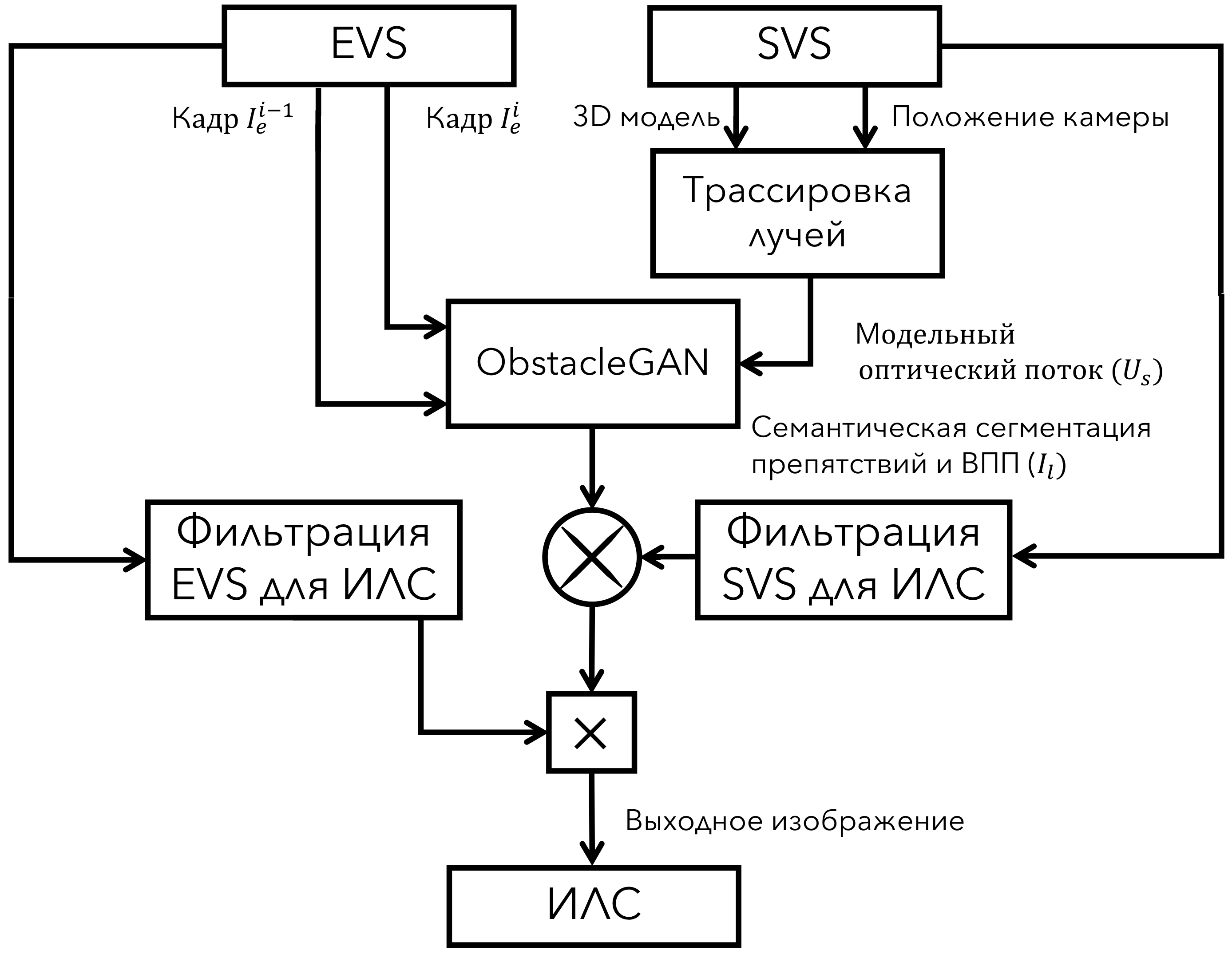

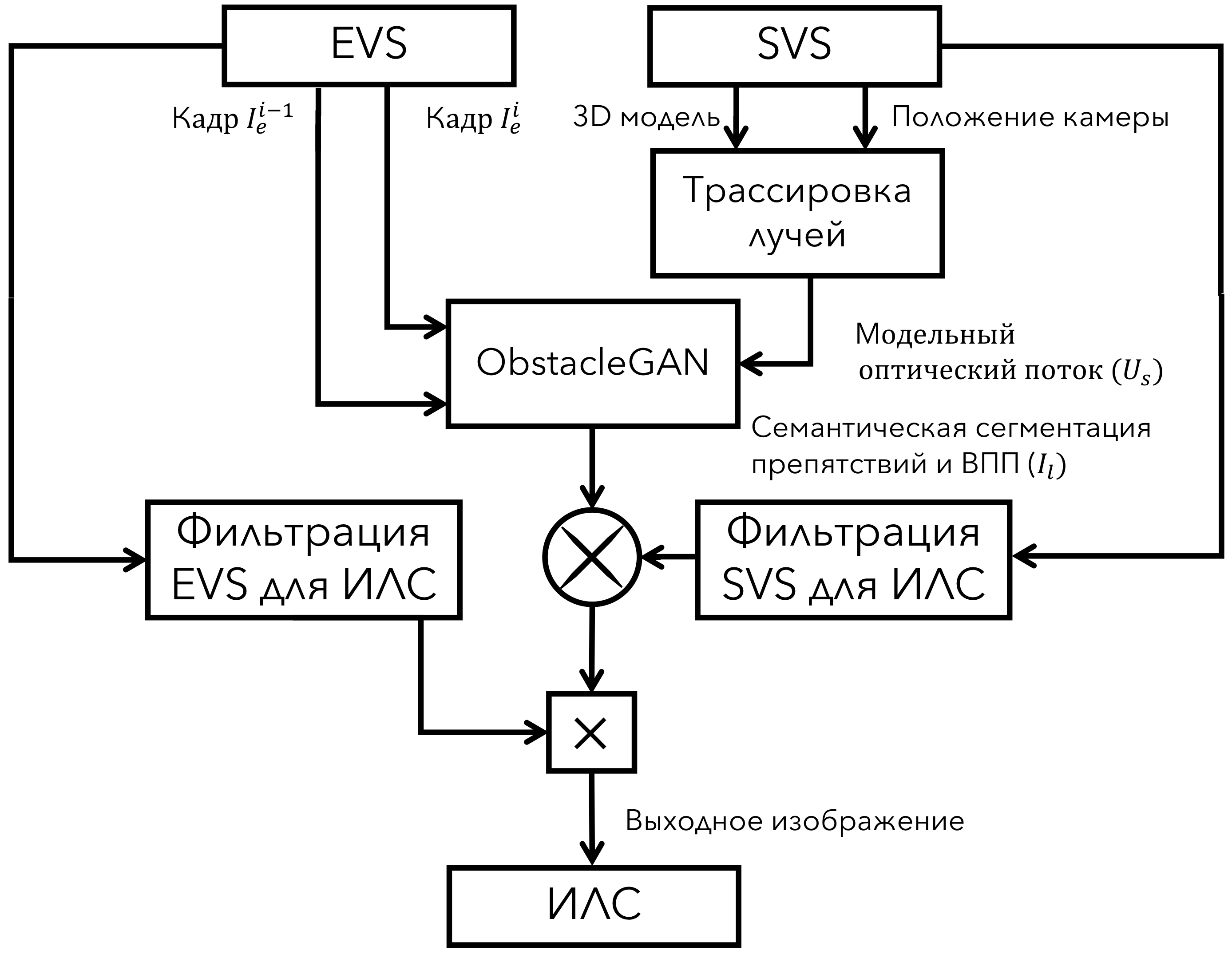

Структурная схема алгоритма. Входными данными для

алгоритма являются последовательности кадров систем синтезированного и

улучшенного видения. На выходе алгоритм выдаёт монохромную

видеопоследовательность, представляющую собой кадр улучшенного видения,

подготовленный для проекции на ИЛС.

Метод комплексирования данных основан на предположении о

том, что эффективному выделению малозаметных препятствий на кадре улучшенного

видения способствует модельный оптический поток кадра синтезированного видения

[6]. Алгоритм принимает следующий набор входных данных: текущий кадр Iir и предыдущий кадр Ii−1r

системы улучшенного видения, текущий кадр системы синтезированного видения IiS, положение виртуальной камеры Xi , Xi−1для

текущего и предыдущих кадров, а также трёхмерную модель сцены, заданную

системой синтезированного видения. На первом этапе производится оценка

модельного оптического потока Us с использованием

метода трассировки лучей. Затем два последовательных кадра системы улучшенного

видения и модельный оптический поток подаются на вход глубокой свёрточной

нейронной сети ObstacleGAN.

Следующим этапом является предварительная обработка кадров

системы улучшенного и синтезированного видения. Предварительная обработка кадра

синтезированного видения заключается в отрисовке трёхмерной модели сцены с

использованием специальной монохромной палитры. В данной палитре наиболее

высокая яркость присвоена наиболее важным визуальным ориентирам (разметка ВПП,

горы). Предварительная обработка кадров системы синтезированного видения

выполняется с использованием модифицированного алгоритма «Retinex» [4, 7].

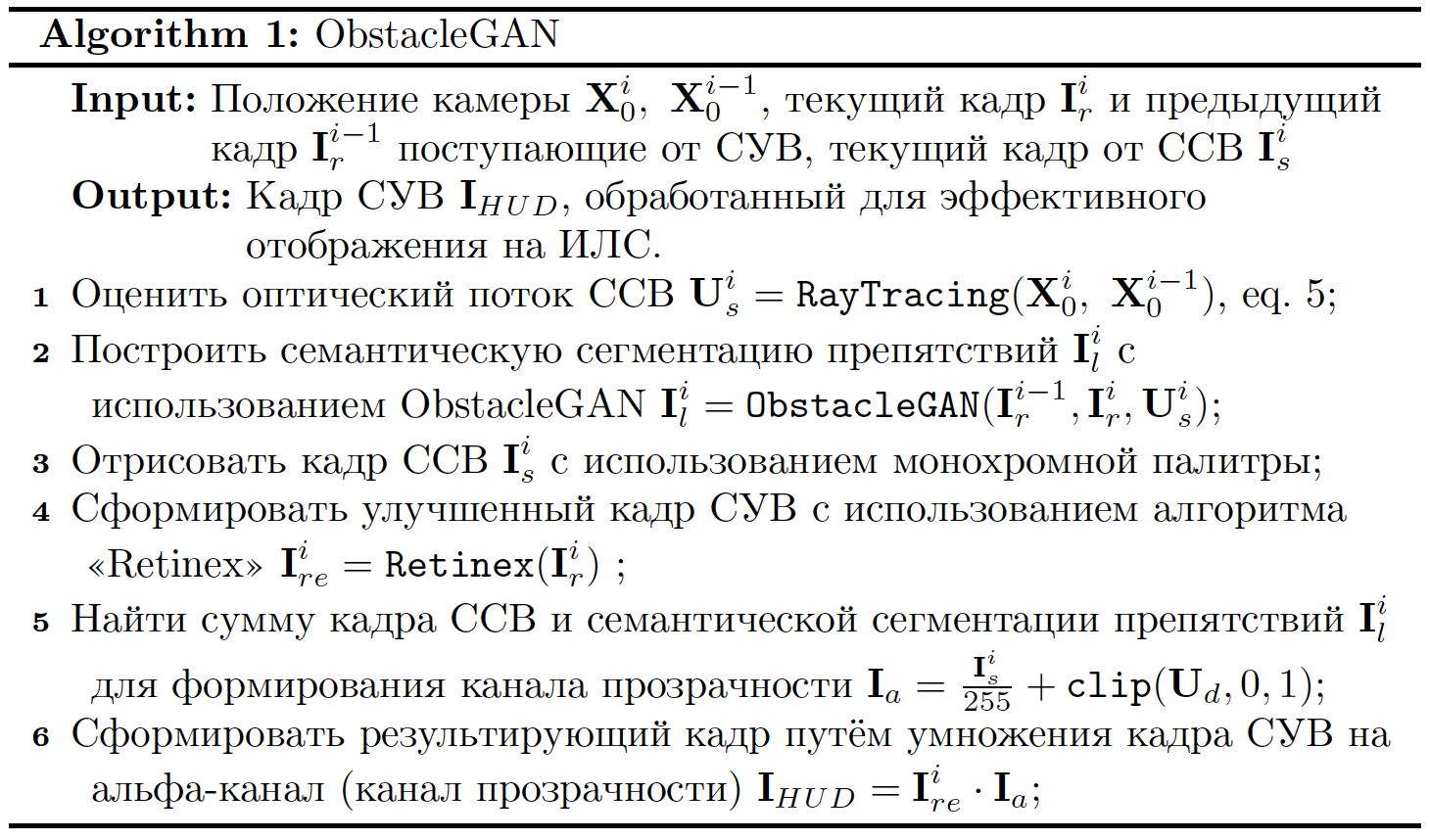

Листинг

1. Словесное описание алгоритма

На следующем этапе формируется канал прозрачности, заданный

семантической сегментацией препятствий Is и

предварительно обработанным кадром системы синтезированного видения.

Изображение Ia представляет собой канал прозрачности

кадра, который будет отображён на ИЛС. Для построения окончательного

изображения предварительно обработанный кадр системы синтезированного видения

умножается на канал прозрачности Ia

Структурная схема алгоритма представлена на рисунке Рисунок 2. Словесное описание алгоритма приведено в

листинге Листинг 1.

Рисунок 2: Словесное описание алгоритма.

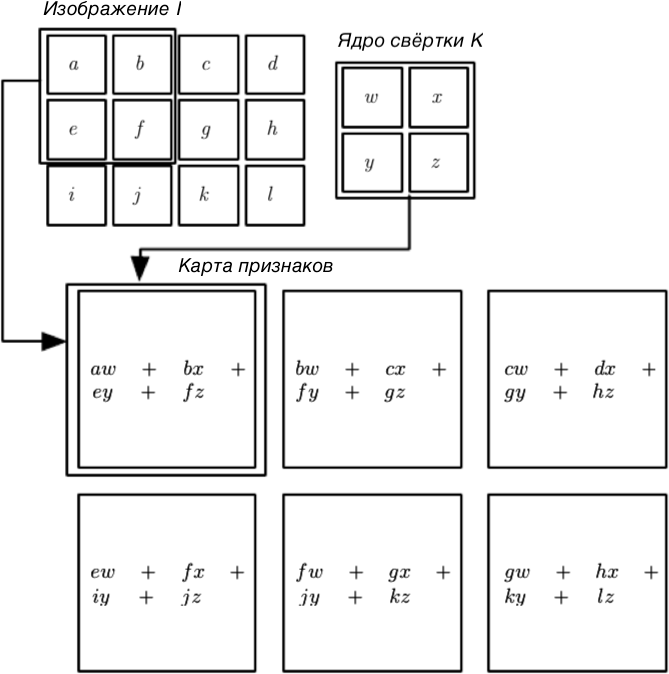

Глубокие свёрточные нейронные сети. Глубокие

свёрточные нейронные сети [8] являются особым случаем нейронных сетей для

обработки данных, представляющих собой значения, распределённые по равномерной

сетке. Примером таких данных являются изображения, которые представляют собой

двумерную сетку. Термин свёрточные нейронные сети применяется ко всем сетям, в

которых используется математическая операция свёртки. Таким образом, свёрточная

нейронная сеть – это нейронная сеть, которая использует операцию свёртки вместо

перемножения матриц хотя бы в одном из слоёв.

В общем случае операция свёртки имеет вид

(1)

или с использованием оператора свёртки

(2)

В литературе, посвящённой свёрточным нейронным сетям, первый

аргумент (функция x) принято называть входным сигналом, а второй аргумент

(функция w) – принято называть ядром свёртки. Результат операции свёртки

принято называть картой признаков. Для дискретного случая уравнение (1)

принимает вид

(3)

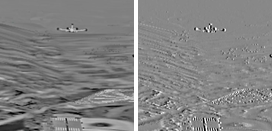

Для двумерного случая на вход поступает изображение I, и

ядро свёртки K также представляет собой двумерный массив

(4)

Пример операции двумерной свёртки приведён на рисунке Рисунок 4. Суть процесса обучения заключается в

подборе коэффициентов ядра свёртки, обеспечивающих выделение характерных черт

на изображении. Операция свёртки многократно повторяется, при этом на вход

каждого следующего слоя сети подаются карты признаков, сформированные

предыдущими слоями. В силу того, что операция свёртки производит снижение

разрешения входного сигнала, последовательное применение нескольких свёрточных

слоёв приводит к снижению пространственного разрешения изображения и увеличению

числа карт признаков. Цель процесса обучения – найти такие ядра свёртки,

которые обеспечивают выделение характерных признаков, необходимых для решения

поставленной задачи. Пример построения карты признаков приведён на рисунке Рисунок 3.

Рисунок 3: Пример построения карты признаков. Слева –

входное изображение, справа – карта признаков.

Рисунок 4: Пример операции двумерной свёртки.

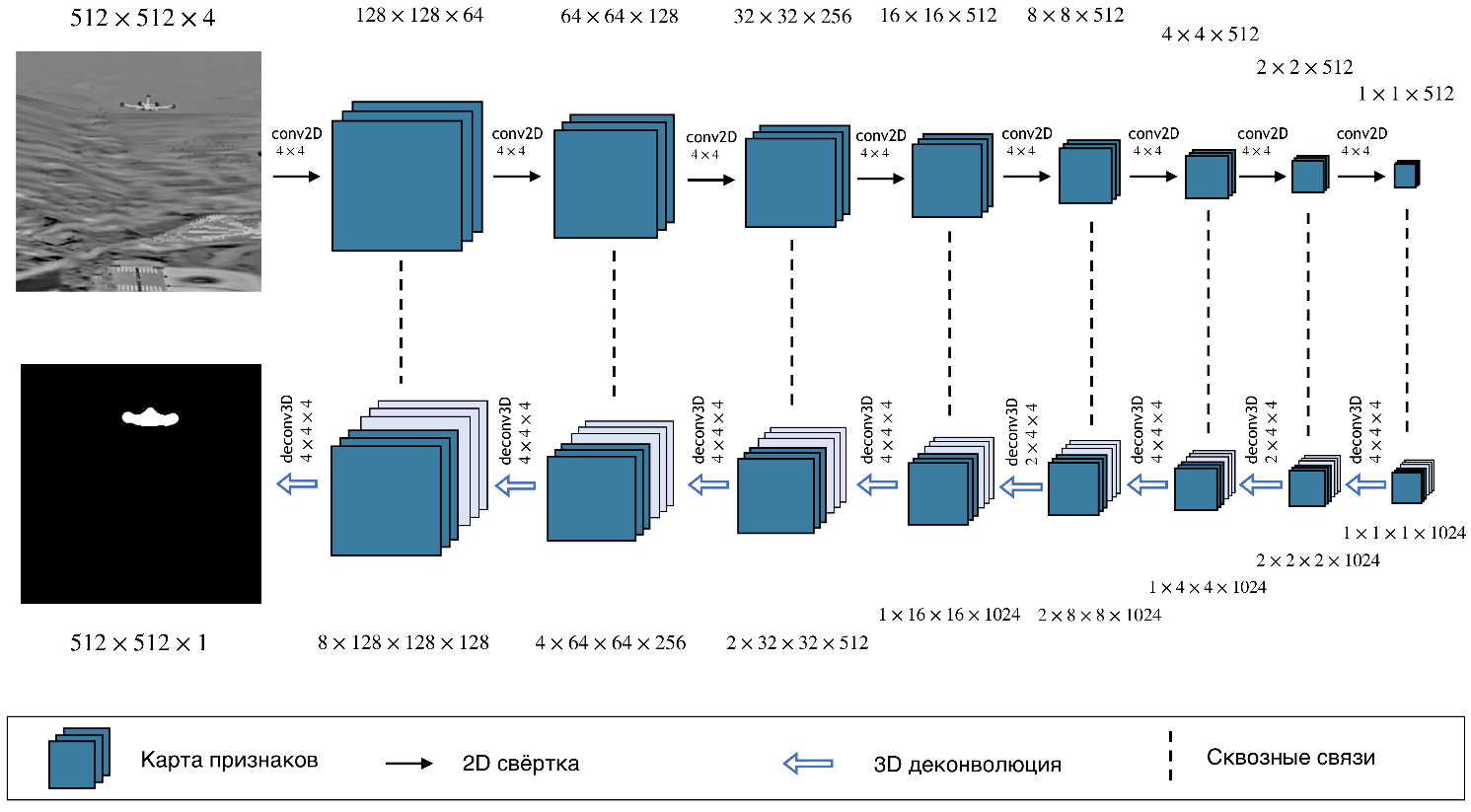

Архитектура сети ObstacleGAN основана на архитектуре

генеративно-состязательной сети pix2pix [9] и состоит из двух подсетей:

генератора  и

дискриминатора

и

дискриминатора  .

Генеративно-состязательные сети формируют сигнал

.

Генеративно-состязательные сети формируют сигнал  для

случайного вектора шума

для

случайного вектора шума  ,

,  [9,

10]. Условные генеративно-состязательные сети преобразует входное изображение

[9,

10]. Условные генеративно-состязательные сети преобразует входное изображение  и вектор

и вектор  в

выходное изображение

в

выходное изображение  ,

,

.

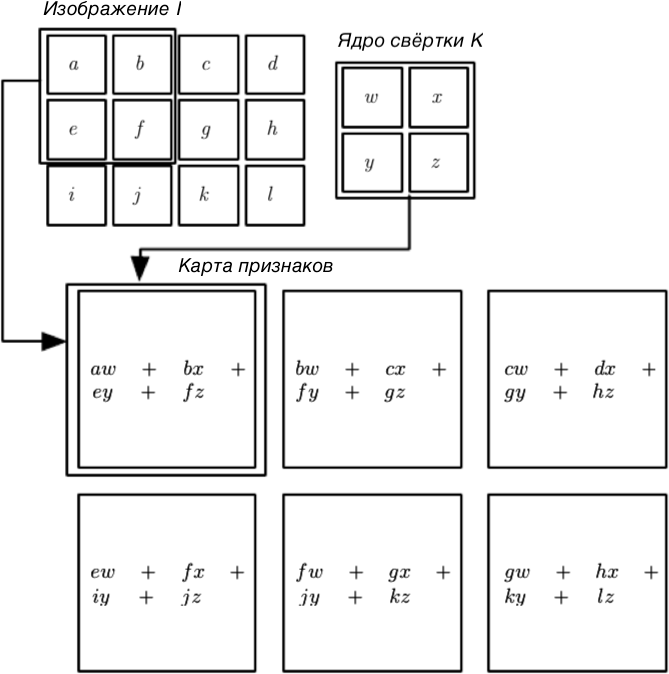

Для сети ObstacleGAN входной тензор

.

Для сети ObstacleGAN входной тензор  включает два

последовательных кадра системы улучшенного видения и модельный оптический

поток. Входной тензор

включает два

последовательных кадра системы улучшенного видения и модельный оптический

поток. Входной тензор  обрабатывается сетью генератора

обрабатывается сетью генератора  . Сеть

дискриминатор

. Сеть

дискриминатор  обучается

отличать истинные выходные изображения

обучается

отличать истинные выходные изображения  от

изображений

от

изображений  ,

создаваемых генератором. Обе сети обучаются одновременно. Основной задачей

дискриминатора является реализация состязательной функции потерь, благодаря

которой генератор стремится формировать изображения

,

создаваемых генератором. Обе сети обучаются одновременно. Основной задачей

дискриминатора является реализация состязательной функции потерь, благодаря

которой генератор стремится формировать изображения  ,

которые нельзя отличить от реальных изображений

,

которые нельзя отличить от реальных изображений  .

.

Подсеть генератор обучается  для

формирования семантической сегментации препятствий

для

формирования семантической сегментации препятствий  ,

обусловленной входным тензором

,

обусловленной входным тензором  .

Архитектура сети генератора приведена на рисунке Рисунок 5.

.

Архитектура сети генератора приведена на рисунке Рисунок 5.

Рисунок 5: Архитектура сети генератора ObstacleGAN.

Структура выборки. Для обучения сети ObstacleGAN были

созданы 4 выборки с различными условиями, каждая из которых состояла из 1000

изображений размером 512x512 пикселей. Структура

обучающей выборки представлена в таблице 1.

Таблица 1. Структура обучающейся выборки.

|

Сценарий

|

Распределение

|

Условия

|

Количество изображений

|

|

Посадка

|

Обучение

|

Туман

|

1000

|

|

Посадка

|

Обучение

|

Синтезированное видение

|

1000

|

|

Посадка

|

Обучение

|

Изображения с препятствием

|

1000

|

|

Посадка

|

Обучение

|

Изображения с меткой

|

1000

|

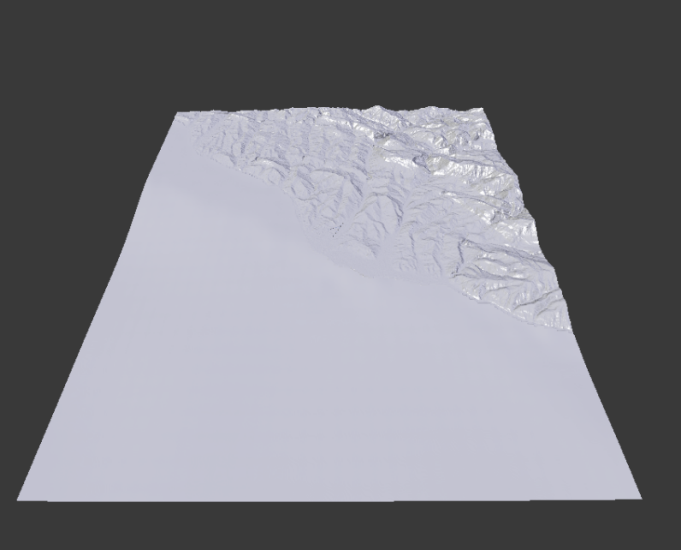

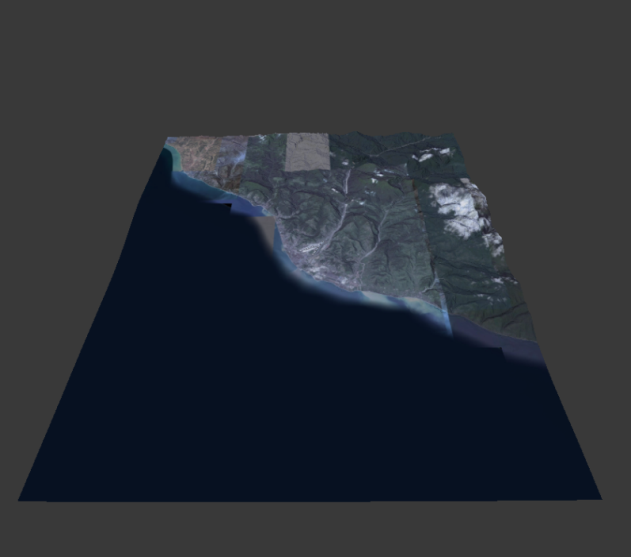

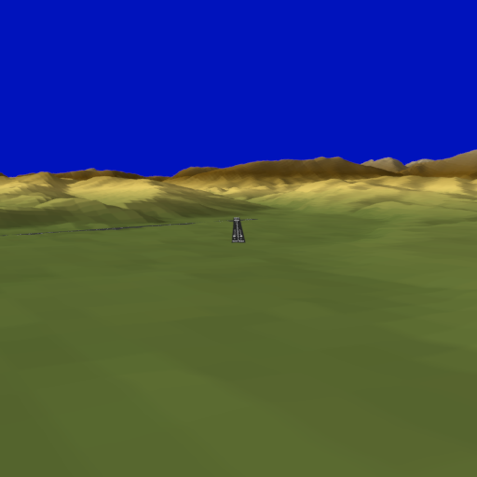

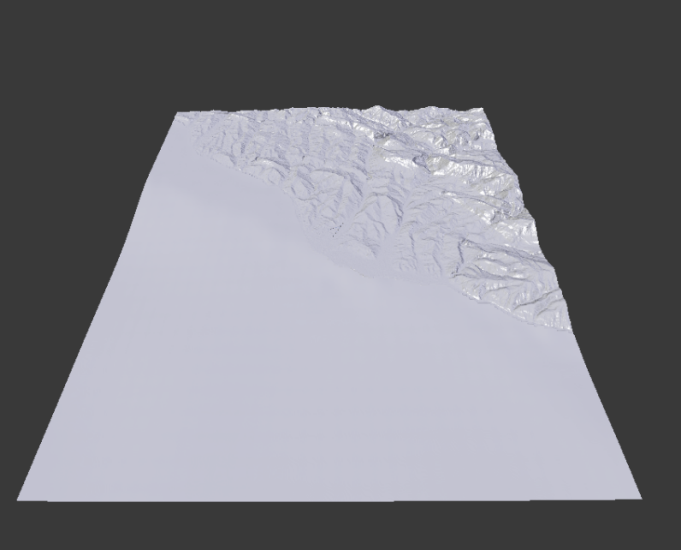

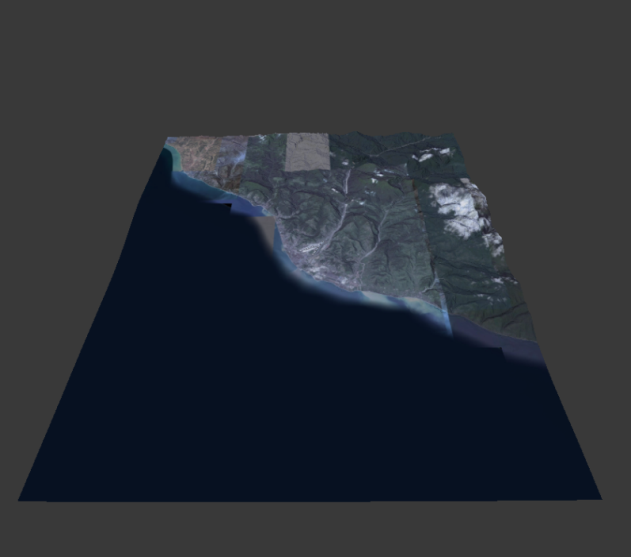

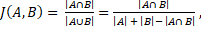

Построение трёхмерной модели района аэропорта Сочи. Для

подготовки обучающей выборки произведено построение трёхмерной модели с

текстурами в среде трёхмерного моделирования Blender.

Данная среда трёхмерного моделирования позволяет производить загрузку цифровых

моделей рельефа и отображать их в виде полигональной модели. Для моделирования

рельефа в районе аэропорта Сочи использовались данные Shuttle Radar Topography Mission (SRTM). Процесс построения трёхмерной

модели производился в два этапа: построение трёхмерной модели ландшафта (Рисунок 6 (Слева)) и наложение текстур на основе спутниковых снимков (Рисунок 6 (Справа)).

Рисунок 6: (Слева) Трехмерная модель ландшафта.

(Справа) Трёхмерная модель ландшафта с текстурой.

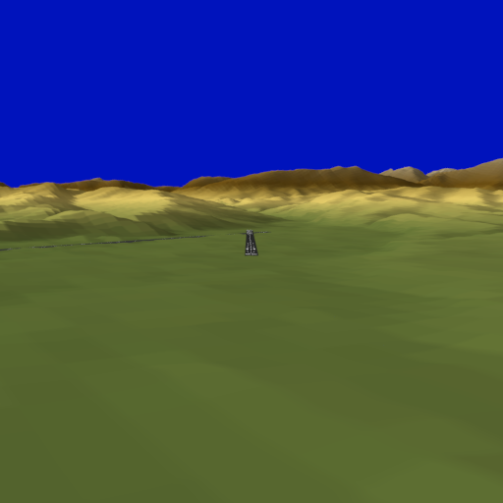

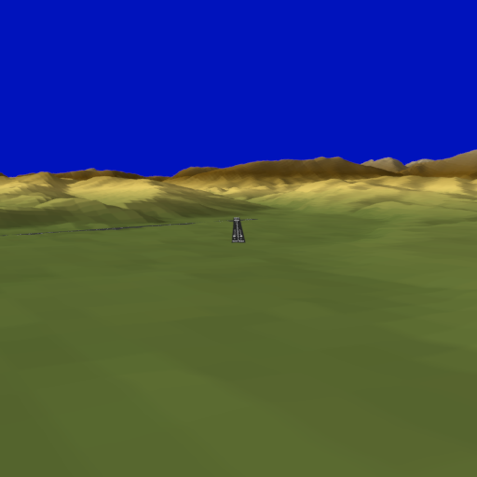

После построения трёхмерной модели (Сочи, район

международного аэропорта Адлер, 30х30 км) был разработан сценарий движения

самолёта, имитирующий движение воздушного суда по стандартной глиссаде при

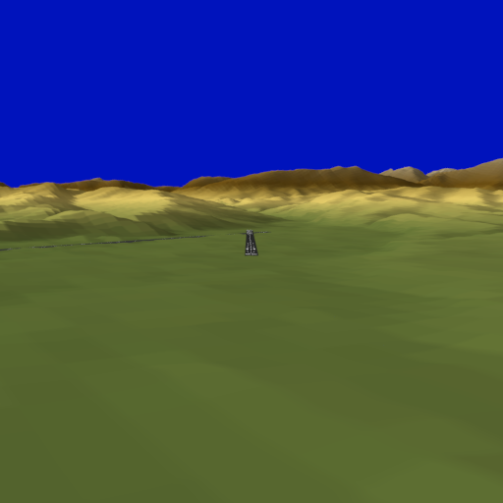

заходе на посадку. Данный сценарий позволил создать выборку изображений,

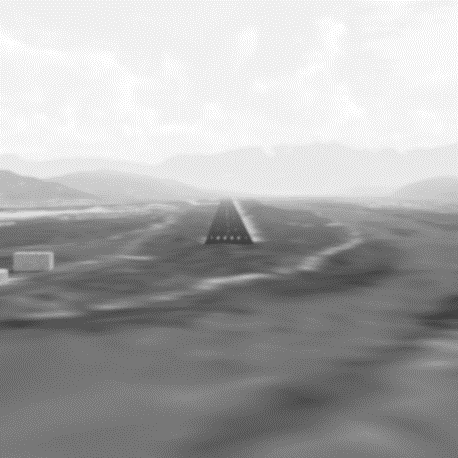

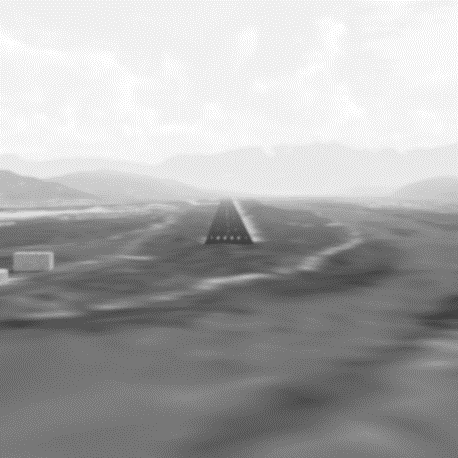

имитирующих работу системы синтезированного видения (Рисунок

7 (Слева)) и изображений системы улучшенного видения диапазона (Рисунок 7 (Справа)). Выборка состоит из 1000 пар геометрически выровненных изображений.

Рисунок 7: (Слева) Синтезированное изображение. (Справа)

Изображение видимого диапазона

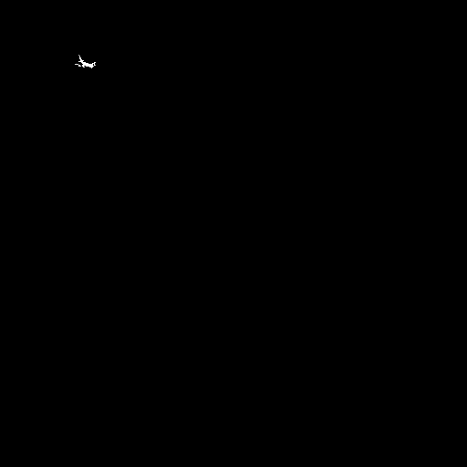

Моделирование появления самолёта, пересекающего

траекторию движения. Для обучения сети, в смоделированную сцену была

добавлена модель самолета (Рисунок 8 (Слева)). Траектория движения самолёта

была выбрана таким образом, что на каждом кадре, в среднем, размер самолёта составлял

от 40 до 200 пикселов. Для тестирования и обучения сети были также построены

меточные изображения, в которых область препятствия была заполнена белым

цветом, а остальная область – чёрным (Рисунок 8 (Справа)).

Рисунок 8:(Слева) Изображение видимого диапазона.

(Справа) Меточное изображение.

Обучение сети ObstacleGAN. Обучение разработанной

сети ObstacleGAN производилось с использованием библиотеки PyTorch [12].

Вычисления производились на графическом процессоре NVIDIA 1080 Ti. Полный

процесс обучения занял 40 часов. В качестве обучающей выборки использовались

данные, полученные методом трёхмерного моделирования с использованием стенда

прототипирования информационно-управляющего поля кабины экипажа.

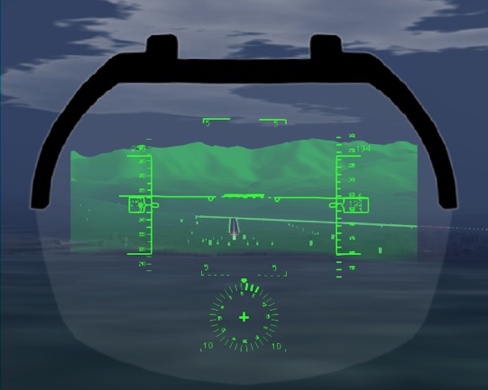

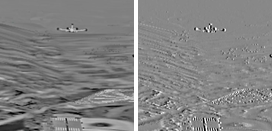

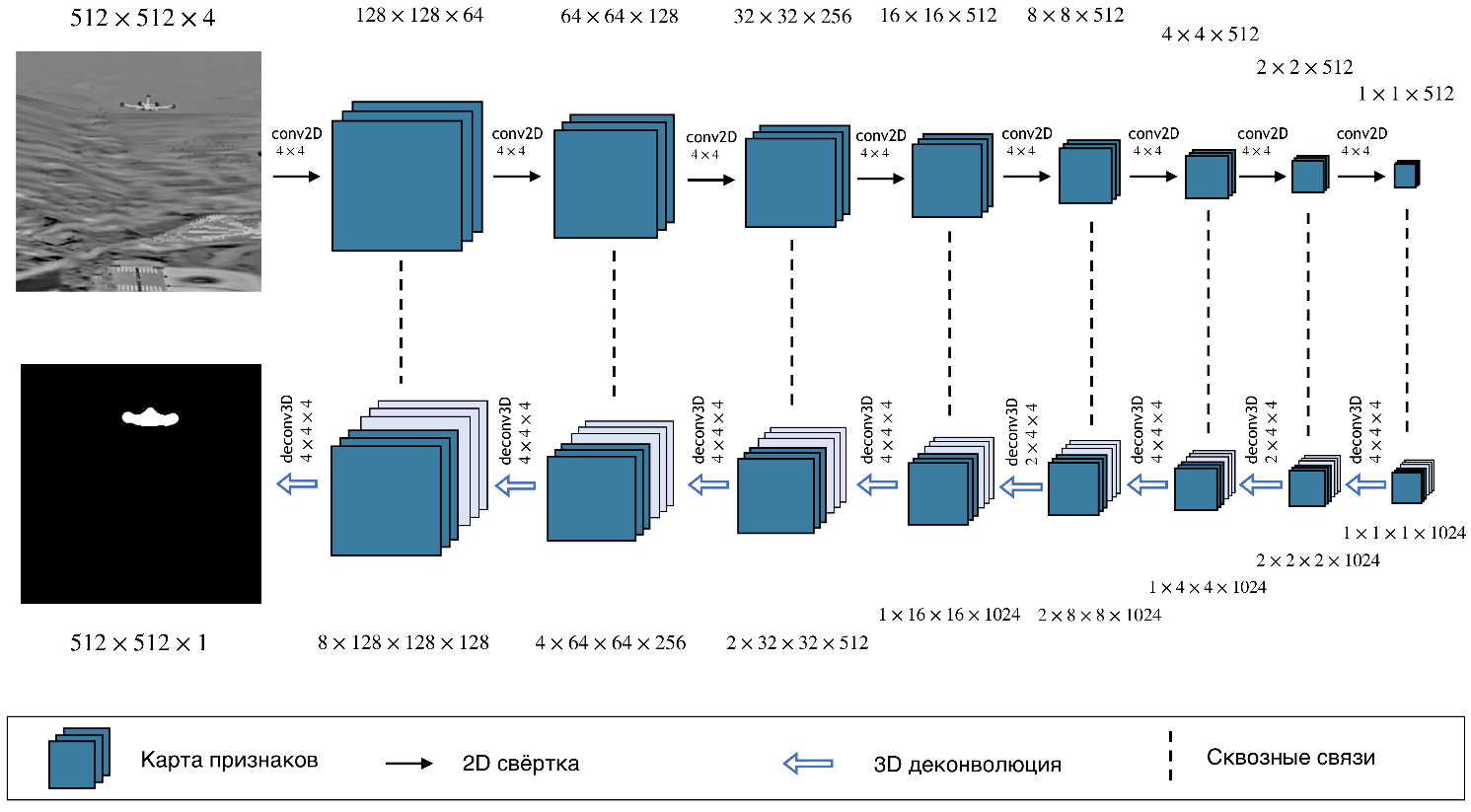

Качественное тестирование. С использованием сформированной

обучающей выборки произведена сравнительная оценка информативности исходного

кадра системы улучшенного видения и результата фильтрации с использованием

алгоритма ObstacleGAN. Для оценки качества были сформированы десять пар

видеопоследовательностей, моделирующие различные этапы полёта. Каждая пара

включает в себя исходную видеопоследовательность, поступающую от системы

улучшенного видения, и результат работы алгоритма ObstacleGAN. Данные

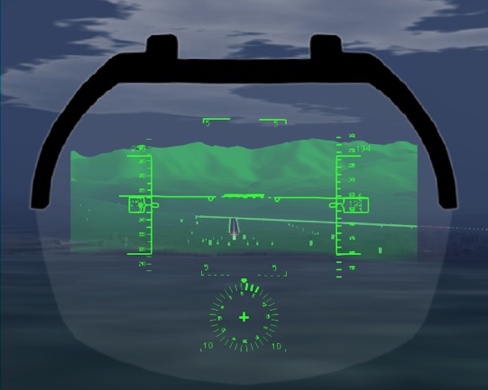

видеопоследовательности были отображены с использованием программного имитатора

ИЛС. Примеры кадров из видеопоследовательностей представлены на рисунке Рисунок 9. Для каждой видеопоследовательности была

произведена оценка повышения яркости динамических препятствий.

Результаты тестирования представлены в таблице Таблица 2.

Рисунок 9: Примеры обработки изображений с помощью

алгоритма ObstacleGAN. (Слева) исходный кадр СУВ. (Справа) результат обработки.

Таблица

2. Сравнительная оценка информативности исходного кадра СУВ и кадра СУВ

после обработки алгоритмом ObstacleGAN

|

Сценарий

|

Освещённость

|

Процент непригодных видео

|

Выбор ObstacleGAN

|

|

Посадка

|

день

|

3.1% ± 1.5%

|

74.2% ± 3.1%

|

|

Посадка

|

ночь

|

5.5% ± 2.4%

|

61.1% ± 2.7%

|

|

Рулёжка

|

день

|

1.6% ± 2.1%

|

85.3% ± 2.6%

|

|

Рулёжка

|

ночь

|

8.7% ± 3.7%

|

59.5% ± 1.7%

|

|

Взлёт

|

день

|

2.2% ± 1.8%

|

81.7% ± 1.2%

|

|

Взлёт

|

ночь

|

7.4% ± 2.9%

|

45.1% ± 5.4%

|

Произведено моделирование появления динамических препятствий

(типа самолёт, пересекающий траекторию движения, и транспортное средство на поверхности

взлётно-посадочной полосы). Вероятность правильного обнаружения динамических

препятствий оценивалась с использованием истинной семантической сегментации,

представляющих собой бинарные изображения, на которых область препятствия

заполнена единицами. Остальная часть изображения заполняется нулями. Для

тестирования использовался коэффициент Жаккара (метрика Intersection over

Union, IoU), определяемый следующим образом

(8)

где А - истинная область препятствия, В - область

препятствия, найденная алгоритмом. Тестирование на независимой выборке

показало, что в среднем коэффициент Жакаара для дневных

видеопоследовательностей составил 0,88, а для ночных видеопоследовательностей –

0,75. Данные значения удовлетворяют заданным требованиям по вероятностям

обнаружения препятствий и обеспечивают стабильную индикацию динамических

препятствий на ИЛС.

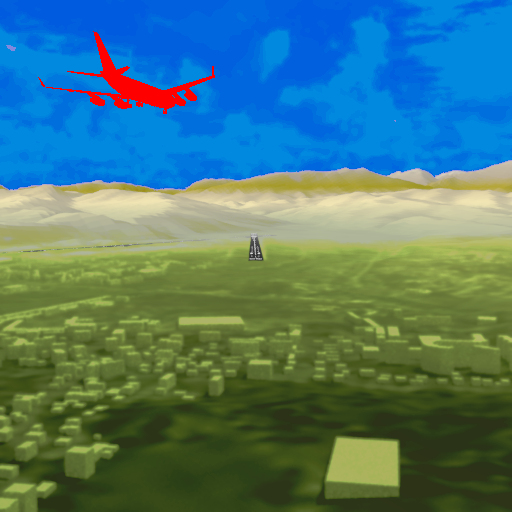

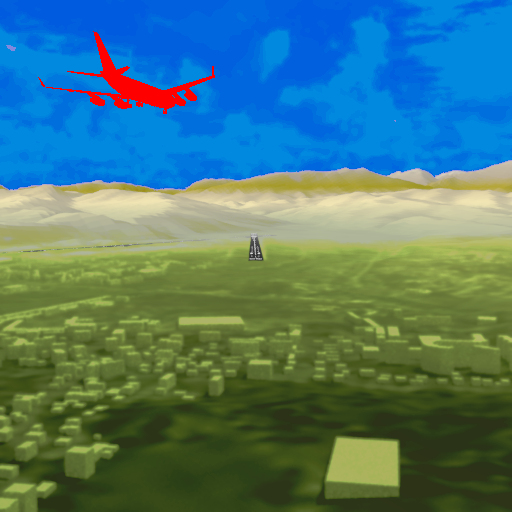

Предложенный алгоритм выделения препятствий также может быть

использован для визуализации препятствий на кадре системы улучшенного видения. Целью

данной визуализации является повышение заметности препятствия для увеличения

дальности обнаружения препятствий. Для реализации данного режима кадры систем

улучшенного и синтезированного видения комплексируются (система

комбинированного видения) после чего область препятствия, выделенная с помощью

сети ObstacleGAN, закрашивается условным красным

цветом. Результат работы алгоритма выделения препятствий при визуализации на

первичном индикаторе пилота приведён на рисунке Рисунок 10.

Рисунок 10: Результат работы алгоритма выделения

препятствий при визуализации на первичном индикаторе пилота: (слева) Система синтезированного

видения, (в центре) Система улучшенного видения, (справа) Результат выделения

препятствия (красный цвет) и комплексирования данных систем улучшенного и

синтезированного видения.

Разработан алгоритм ObstacleGAN, производящий снижение

яркости малоинформативных областей и повышение яркости динамических

препятствий. Алгоритм использует видеопоследовательности от систем улучшенного

и синтезированного видения в качестве входных данных и производит

комплексирование кадров двух систем для снижения яркости малоинформативных

областей в кадре системы улучшенного видения и увеличения яркости динамических

препятствий.

Уменьшение яркости выполняется на основе сегментации

областей из кадра системы синтезированного видения. Для повышения яркости

динамических препятствий производится их обнаружение на основе вычисления

разности оптических потоков кадров систем улучшенного и синтезированного

видения. Реальный оптический поток оценивается по видеопоследовательности

системы улучшенного видения. Модельный оптический поток рассчитывается с

помощью трассировки лучей и 3D модели сцены системы синтезированного видения.

Разработанный алгоритм производит параллельную обработку

данных и может быть реализован на платформе современной интегрированной

модульной авионики. Вычислительная сложность алгоритма позволяет реализовать

его для обработки кадров системы улучшенного видения с разрешением 640´480 пикселей, с использованием 3

процессоров с тактовой частотой 1,8 ГГц и одного графического процессора NVIDIA

Tegra. Дальнейшая работа будет посвящена реализации и тестированию алгоритма

ObstacleGAN с использованием бортового оборудования.

Работа выполнена при поддержке Российского фонда

фундаментальных исследований, грант РФФИ №17-29-03185.

1.

Kniaz V V. Fast instantaneous center of rotation estimation

algorithm for a skied-steered robot // SPIE Optical Metrology. –– 2015. –– Jun.

–– Vol. 9528. – P. 95280L–95280L–11.

2.

Kniaz V V. Real-time optical flow estimation on

a GPU for a skied-steered mobile robot. –– 2016. –– Apr. –– P.

989706–989706–12.

3. Kniaz

V. V., Gorbatsevich V. S., Mizginov V. A. THERMALNET: A DEEP CONVOLUTIONAL NETWORK

FOR SYNTHETIC THERMAL IMAGE GENERATION // ISPRS – International Archives of the

Photogrammetry, Remote Sensing and Spatial Information Sciences. –– 2017. ––

Vol. XLII-2/W4. –– P. 41–45. –– URL: http://www.intarch-

photogramm-remote-sens-spatial-inf-sci.net/XLII-2- W4/41/2017/.

4. Krizhevsky

A, Sutskever I, Hinton G E. Imagenet classification with deep convolutional

neural networks // Advances in Neural Information Processing Systems. –– 2012

5. Long

J., Shelhamer E., Darrell T. Fully convolutional networks for semantic

segmentation // IEEE Conference on Computer Vision and Pattern Recognition

(CVPR). –– 2015.

6. Long

J., Shelhamer E., Darrell T. Fully Convolutional Models for Semantic

Segmentation // CVPR 2015, and PAMI 2016. –– 2016.

7. Semantic

image segmentation for information presentation in enhanced vision / Oleg V.

Vygolov, Vladimir S. Gorbatsevich, Nikita A. Kostromov et al. // Proc. SPIE. ––

2017. –– Vol. 10197. –– P. 101970H–101970H–8. –– URL: http://dx.doi.org/10.1117/12.2262507.

8. SqueezeNet:

AlexNet-level accuracy with 50x fewer parameters and <1MB model size /

Forrest N.Iandola, Matthew W. Moskewicz, Khalid Ashraf et al. // CoRR. –– 2016.

–– Vol. abs/1602.07360. –– URL: http://arxiv.org/abs/1602.07360.

9. The

Pascal Visual Object Classes (VOC) Challenge / Mark Everingham, Luc Van Gool,

Christopher K I Williams et al. // International Journal of Computer Vision. ––

2009. –– Vol. 88, no. 2. –– P. 303–338.

10. Zhang Richard, Isola

Phillip, Efros Alexei A. Colorful Image Colorization. // ECCV. –– 2016. –– Vol.

9907, no. Chapter 40. –– P. 649–666.

11. Zheltov S, Sibiryakov

A. Method of 3d-object detection based on orthophoto difference analysis // International

Archives of Photogrammetry and Remote Sensing. Vol. XXXIII, Part B3. Amsterdam

2000. –– 2000. –– P. 1041–1047.

12. Бусурин В. И., Князь

В. В. Автоматическое обнаружение препятствий на взлётно-посадочной полосе средствами

технического зрения –– Труды МАИ, 2014. –– Т. 81.

13. Князь В. В., Мизгинов

В. А., Горбацевич В. С. Создание модельных изображений инфракрасного диапазона

и оценка их визуального качества с использованием свёрточных нейронных сетей.

–– Научная визуализация, 2016. –– Т. 8. –– С. 67 79.

Segmentation and visualization of obstacles for the enhanced vision system using generative adversarial networks

Authors: V.V. Kniaz1,A,B, S.Yu. Danilov2,A,B, A.N. Bordodymov3,A

A State Res. Institute of Aviation Systems (GosNIIAS), Moscow, Russia

B Moscow Institute of Physics and Technology (MIPT), Russia

1 ORCID: 0000-0003-2912-9986, vl.kniaz@gosniias.ru

2 ORCID: 0000-0003-1346-1685, danilov@gosniias.ru

3 ORCID: 0000-0001-8159-2375, bordodymov@gmail.com

Abstract

An increasing amount of air traffic in general aviation generates a demand to increase the situational awareness of the crew during task intensive stages of the flight such as take-off, landing and taxi. The Head-up Display (HUD) is a prospective device that provides aid for the crew by projection of a flight information over on a display over the cockpit view. Nevertheless, projection of a video sequence on the HUD is challenging due large areas of a high intensity and low contrast of dynamic obstacles (aircraft crossing the flight trajectory and vehicles on a runway).

This paper is focused on the development of an algorithm for detection of dynamic obstacles in the air and on the runway. To achieve this task the algorithm leverages an original deep convolutional neural network ObstacleGAN.The developed algorithm performs parallel data processing and can be implemented using the modern integrated modular avionics. The numerical complexity of the algorithm allows to implement it for processing of enhanced vision system video sequence with resolution of 640?480 pixels using three CPU at 1.8 GHz and one lightweight GPU.

Keywords: aircraft, increasing of a situational awareness, aircraft traffic safety, head-up display, deep convolutional neural networks.

1. Kniaz V V. Fast instantaneous center of rotation estimation algorithm for a

skied-steered robot // SPIE Optical Metrology. –– 2015. –– Jun. –– Vol. 9528. –

P. 95280L–95280L–11.

2. Kniaz

V V. Real-time optical flow estimation on a GPU for a skied-steered mobile

robot. –– 2016. –– Apr. –– P. 989706–989706–12.

3. Kniaz

V. V., Gorbatsevich V. S., Mizginov V. A. THERMALNET: A DEEP CONVOLUTIONAL NETWORK

FOR SYNTHETIC THERMAL IMAGE GENERATION // ISPRS – International Archives of the

Photogrammetry, Remote Sensing and Spatial Information Sciences. –– 2017. ––

Vol. XLII-2/W4. –– P. 41–45. –– URL: http://www.intarch-

photogramm-remote-sens-spatial-inf-sci.net/XLII-2- W4/41/2017/.

4. Krizhevsky

A, Sutskever I, Hinton G E. Imagenet classification with deep convolutional

neural networks // Advances in Neural Information Processing Systems. –– 2012

5. Long

J., Shelhamer E., Darrell T. Fully convolutional networks for semantic

segmentation // IEEE Conference on Computer Vision and Pattern Recognition

(CVPR). –– 2015.

6. Long

J., Shelhamer E., Darrell T. Fully Convolutional Models for Semantic

Segmentation // CVPR 2015, and PAMI 2016. –– 2016.

7. Semantic

image segmentation for information presentation in enhanced vision / Oleg V.

Vygolov, Vladimir S. Gorbatsevich, Nikita A. Kostromov et al. // Proc. SPIE. ––

2017. –– Vol. 10197. –– P. 101970H–101970H–8. –– URL: http://dx.doi.org/10.1117/12.2262507.

8. SqueezeNet:

AlexNet-level accuracy with 50x fewer parameters and <1MB model size /

Forrest N.Iandola, Matthew W. Moskewicz, Khalid Ashraf et al. // CoRR. –– 2016.

–– Vol. abs/1602.07360. –– URL: http://arxiv.org/abs/1602.07360.

9. The

Pascal Visual Object Classes (VOC) Challenge / Mark Everingham, Luc Van Gool,

Christopher K I Williams et al. // International Journal of Computer Vision. ––

2009. –– Vol. 88, no. 2. –– P. 303–338.

10. Zhang Richard, Isola

Phillip, Efros Alexei A. Colorful Image Colorization. // ECCV. –– 2016. –– Vol.

9907, no. Chapter 40. –– P. 649–666.

11. Zheltov S, Sibiryakov

A. Method of 3d-object detection based on orthophoto difference analysis // International

Archives of Photogrammetry and Remote Sensing. Vol. XXXIII, Part B3. Amsterdam

2000. –– 2000. –– P. 1041–1047.

12. Busurin V. I., Knyaz'

V. V. Avtomaticheskoe obnaruzhenie prepyatstvii na vzletno-posadochnoi polose

sredstvami tekhnicheskogo zreniya (Automatic detection of foreign objects on

the runway using computer vision), Trudy MAI (Proceedings of MAI), 2014, V. 81.

13. Knyaz' V. V., Mizginov

V. A., Gorbatsevich V. S. Sozdanie model'nykh izobrazhenii infrakrasnogo

diapazona i otsenka ikh vizual'nogo kachestva s ispol'zovaniem svertochnykh

neironnykh setei (Generation of synthetic infrared images and their visual

quality estimation using deep convolutional neural networks). –– Nauchnaya

vizualizatsiya (Scientific visualization), 2016. V. 8. P. 67–79.