СОЗДАНИЕ МОДЕЛЬНЫХ ИЗОБРАЖЕНИЙ ИНФРАКРАСНОГО ДИАПАЗОНА И ОЦЕНКА ИХ ВИЗУАЛЬНОГО КАЧЕСТВА С ИСПОЛЬЗОВАНИЕМ СВЁРТОЧНЫХ НЕЙРОННЫХ СЕТЕЙ

В.В. Князь, В.C. Горбацевич, В.А. Мизгинов

ГосНИИАС, Москва, Россия

vl.kniaz@gosniias.ru, gvs@gosniias.ru, kevin5garnett-kg@yandex.ru

Содержание

2. Методика построения модельных изображений инфракрасного диапазона

2.3. Критерий качества метода моделирования

2.4. Построение псевдоинфракрасных изображений фоновой обстановки с помощью приведения гистограммы

2.5. Калибровка виртуальной камеры

2.6. Построение трёхмерных моделей

2.7. Прослеживание объектов с использованием алгоритма Z-поток

3. Обучение свёрточной нейронной сети

Аннотация

В настоящее время глубокие свёрточные нейронные сети зарекомендовали себя в качестве мощного инструмента решения задач распознавания объектов на изображениях, обеспечивающего вероятность правильной классификации с качеством, превосходящим возможности человека. Свёрточные сети также предоставляют возможность гибкого подхода к использованию многоспектральных данных, что, в общем случае, повышает вероятность верной классификации за счёт одновременного использования изображений, сделанных в видимом и инфракрасном диапазонах. Указанные качества обусловливают высокий потенциал применения методов машинного обучения для решения задач предупреждения столкновений воздушных судов с препятствиями на взлётно-посадочной полосе.

Залогом успешного обучения свёрточной сети является большой объём и разнообразие обучающей выборки изображений. Но если большие базы изображений видимого диапазона, предназначенные для обучения алгоритмов распознавания изображений (Pascal VOC, MS COCO), достаточно просто найти в открытом доступе, то базы данных изображений инфракрасного диапазона, необходимого состава, объёма и качества, если и существуют, то недоступны для публичного использования.

В статье предложена методика дополнения существующих баз изображений видимого диапазона синтезированными изображениями инфракрасного диапазона. Методика основывается на использовании текстурированных 3D-моделей объектов интереса и построении псевдоинфракрасных фоновых текстур на основе изображений видимого диапазона. Приводится описание разработанного алгоритма совмещения реальных изображений и 3D-моделей и алгоритма прослеживания объектов для обработки видеопоследовательностей. Рассматривается применение разработанной методики с целью построения обучающей выборки для обнаружения препятствий на взлётно-посадочной полосе. Приводится сравнение результатов обучения сети на реальных изображениях инфракрасного диапазона и изображениях, синтезированных с использованием разработанной методики.

Ключевые слова: тепловизионные изображения, дополненная реальность, распознавание объектов, свёрточные нейронные сети, обнаружение объектов на взлётно-посадочной полосе, прослеживание объектов.

1. Введение

Решение задачи обнаружения и распознавания объектов требуется во многих приложениях машинного зрения, в частности, она является весьма важной и актуальной для предупреждения столкновений воздушных судов с препятствиями на взлётно-посадочной полосе. Ежегодный ущерб мировых авиакомпаний от такого рода катастроф оценивается в 13 миллиардов долларов [1]. В работах [16, 4, 17] предложен подход, позволяющий производить автоматическое обнаружение препятствий на взлётно-посадочной полосе на основе видеопоследовательности, поступающей от бортовой камеры. Однако для снижения вероятности ошибок второго рода требуется дополнительная проверка фрагмента изображения, содержащего обнаруженное препятствие для фильтрации ложных срабатываний алгоритма обнаружения. Для этого требуется алгоритм, обеспечивающий высокую вероятность верного определения двух возможных классов объектов на фрагменте изображения, соответствующих препятствию и фону (взлётно-посадочной полосе). Повысить вероятность верного обнаружения препятствия также возможно благодаря использованию при классификации многоспектральных изображений. При этом современные системы улучшенного видения, представляющие базовую платформу для алгоритмов обнаружения препятствий, как правило, включают в себя датчики видимого и инфракрасного диапазонов [19], что создаёт предпосылки для создания алгоритмов обнаружения препятствий, использующих многоспектральные данные.

Сегодня глубокие свёрточные нейронные сети де-факто являются одним из самых совершенных методов распознавания объектов на изображениях, позволяющим превзойти результаты человека в решении задачи верного определения класса объекта. В независимом тестировании алгоритмов распознавания на тестовой базе изображений ImageNet (ILSVRC-2012) [3], проводившемся в 2012 г., алгоритм распознавания на основе топологии свёрточной нейронной сети AlexNet [6] с большим отрывом превзошёл альтернативные подходы к распознаванию. Дальнейшее развитие топологий сети показало, что увеличение числа слоёв сети позволяет повысить результаты распознавания [12]. Благодаря тому, что нейронная сеть автоматически формирует признаки, обеспечивающие наилучшее разделение изображений на заданные классы, обеспечивается возможность гибкого подхода к использованию и комплексированию исходных многоканальных данных для повышения точности распознавания объектов [15].

Для достижения высокой вероятности верного распознавания заданных классов объектов требуется обширная обучающая выборка, включающая более 50 000 изображений на класс. Также, для обеспечения успешного обучения свёрточной сети, обучающая выборка должна включать в себя изображения объекта, сделанные:

· со всех допустимых ракурсов;

· при всех возможных погодных условиях;

· при всех возможных вариантах окраски;

· при всех возможных положениях источника света;

· при всех возможных вариантах фона.

В случае, если обучающая выборка не удовлетворяет данным требованиям, возможно переобучение обученной сети: запоминание конкретных образцов изображений из обучающей выборки. Для обучения свёрточных нейронных сетей в настоящее время собраны и доступны в открытом доступе большие базы изображений видимого диапазона объектов различных классов [3, 9]. Однако обучение сетей для распознавания многоспектральных изображений вызывает значительные сложности вследствие отсутствия представительных обучающих выборок, составленных из реальных изображений. Существующие обучающие выборки, составленные из изображений, синтезированных с использованием трёхмерной графики [13, 11, 10] не обеспечивают достаточного разнообразия фона для качественного обучения нейронной сети.

Это обусловливает актуальность решения задачи создания обширных обучающих выборок многоспектральных изображений. Эффективным подходом к созданию подобных обучающих выборок является построение синтезированных инфракрасных изображений на основе существующей выборки изображений или видеопоследовательностей видимого диапазона. Данный подход позволяет дополнить существующие обширные обучающие выборки изображений видимого диапазона для решения задач обучения свёрточных нейронных сетей.

Данная работа посвящена разработке методики построения синтезированных изображений инфракрасного диапазона на основе существующих изображений видимого диапазона и трёхмерных моделей объектов интереса. Рассматриваются вопросы автоматизированной калибровки виртуальной инфракрасной камеры и разметки видеопоследовательности. Приводится сравнение полученных модельных изображений с реальными инфракрасными изображениями той же сцены с использованием базы многоспектральных изображений DARPA VIVID [8]. В заключении приводится анализ результатов обучения свёрточной нейронной сети на изображениях, построенных с использованием разработанной методики.

2. Методика построения модельных изображений инфракрасного диапазона

Рассматриваемый подход основывается на построении псевдоинфракрасного изображения фоновой обстановки на основе изображения видимого диапазона. Полученное фоновое изображение дополняется фрагментами модельных изображений, построенных с использованием трёхмерных полигональных моделей объектов интереса. Для автоматизации данного процесса используется калибровка виртуальной камеры по трёхмерной модели объекта интереса и автоматическое прослеживание объекта интереса с использованием алгоритма Z-поток [5].

2.1. Постановка задачи

Дана видеопоследовательность реальных изображений объекта интереса (препятствие) и фоновой обстановки (взлётно-посадочная полоса) видимого диапазона. Требуется произвести построение синхронизированных модельных изображений инфракрасного диапазона на основе заданной видеопоследовательности видимого диапазона для обучения свёрточной нейронной сети. Адекватность полученных синтезированных изображений необходимо проверить, используя тестовую базу многоспектральных изображений, а также критерий оценки качества метода моделирования.

2.2. Предлагаемый подход

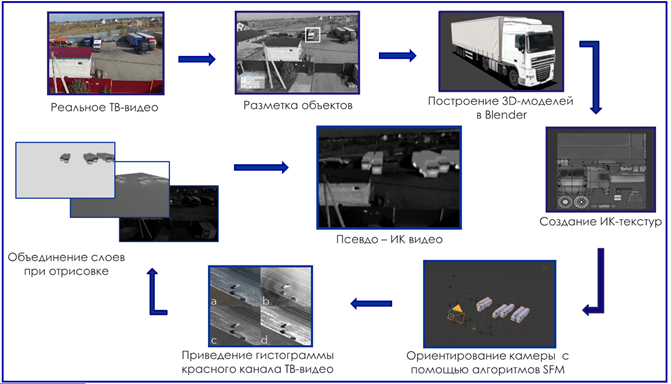

Основной целью предлагаемой методики является повышение скорости построения больших баз модельных изображений инфракрасного диапазона, а также максимальная автоматизация всех этапов. В основе разработанной методики лежит подход, применяемый в системах дополненной реальности, когда на реальное изображение фона накладывается синтезированное изображение объекта интереса. Существенным отличием предлагаемой методики является предварительная обработка фонового изображения с использованием метода приведения гистограмм. Данный подход позволяет получить на основе фонового изображения видимого диапазона заданной сцены псевдоинфракрасное фоновое изображение той же сцены, наблюдаемое виртуальной инфракрасной камерой из той же точки. После построения фонового изображения, производится отрисовка слоя трёхмерной модели объекта интереса, который накладывается поверх фона. Процесс построения модельной псевдоинфракрасной видеопоследовательности показан на рисунке 1.

Рис. 1. Этапы построения псевдоинфракрасной видеопоследовательности.

2.3. Критерий качества метода моделирования

Важной задачей при создании синтезированных изображений средствами трёхмерного моделирования является оценка качества построенных изображений. Критерий качества изображения существенно зависит от решаемой задачи. Например, для восприятия оператором, более качественным по сравнению с исходным изображением, полученным в условиях тумана, является изображение, обработанное с использованием алгоритма повышения контраста. Однако, для алгоритма кросс-корреляции более качественными является необработанное изображение, сохранившие исходные контрасты.

Наиболее широко используемыми подходами к оценке качества являются: экспертная оценка, сравнение с эквивалентными реальными изображениями и использование мер качества изображений. Применение данных подходов для оценки качества моделирования больших баз данных, используемых для обучения глубоких конволюционных сетей является затруднительным.

Оценка эксперта зачастую оказывается существенно смещённой или просто неверной, Так, обучение на базе модельных изображений, оцененных экспертом как визуально соответствующих действительным инфракрасным изображениям, не даёт высокой вероятности правильного распознаваний при тестировании на реальных изображениях. Сравнение с реальными данными может быть не возможным, вследствие малого числа реальных изображений. Меры качества изображения не могут быть использованы в силу того, что они, также, как и экспертная оценка, дают субъективную оценку визуальной информативности (пригодности для восприятия человеком-оператором).

Важнейшим требованием к изображениям при построении обучающих выборок является возможность обучения на них нейронной сети. Поэтому в данной работе качество синтезированных изображений определяется сходством текстур и контрастов объектов интереса на модельных изображениях и аналогичных параметров реальных изображений.

Для исключения субъективности оценки предлагается использовать критерий качества, основанный на вероятности правильного распознавания обученной сети. Предлагаемый подход заключается в следующем. Пусть дана выборка из N реальных изображений IR, предназначенных для тестирования заданного алгоритма распознавания. С помощью разработанного метода моделирования M сформируем выборку из N модельных изображений IM, моделирующих сцены, представленных на реальных изображениях IR. Проведём тестирование алгоритма распознавания на реальных изображениях IR и модельных изображений IM и найдём оценки вероятности правильного распознавания AUCR и AUCM с помощью какого-либо метода, например, площади под кривой ошибок – Area Under Curve (AUC) [20]. Если качество распознавания не меняется от используемой тестовой выборки, то для рассматриваемого алгоритма модельные изображения хорошо соответствуют реальным изображениям. Тогда критерий качества метода моделирования J, можно определить как отношение качества распознавания заданного алгоритма, обученного на реальных и модельных изображениях:

![]() (1)

(1)

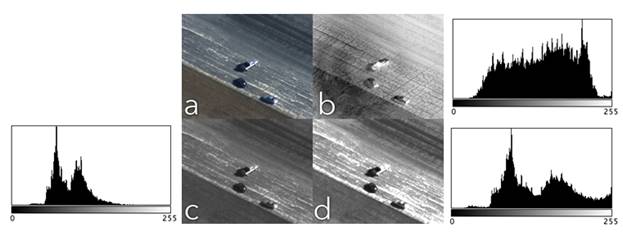

2.4. Построение псевдоинфракрасных изображений фоновой обстановки с помощью приведения гистограммы

Для обеспечения разнообразия изображений фоновой обстановки предлагается произвести приведение гистограммы имеющегося изображения фоновой обстановки в видимом диапазоне к гистограмме обобщённого изображения инфракрасного диапазона [18]. Пример полученного изображения фоновой обстановки приведён на рисунке 2-d. Для его построения был использован красный канал исходного изображения (рис. 2-c), гистограмма которого была приведена к гистограмме инфракрасного изображения (рис. 2-b).

Рис. 2. Пример построения псевдоинфракрасного фонового изображения: a – исходное цветное изображение видимого диапазона из базы VIVID; b – изображение инфракрасного диапазона с заданной гистограммой; с – красный канал исходного цветного изображения; d – красный канал исходного цветного изображения после приведения гистограммы.

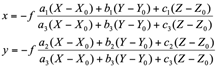

2.5. Калибровка виртуальной камеры

Требование синхронизации инфракрасных изображений с изображениями видимого диапазона (то есть получение модельных изображений с параметрами съемки, соответствующими камере видимого диапазона) обусловливает необходимость выполнения процедуры оценки параметров камеры, применявшейся для съёмки в видимом диапазоне, и создания в среде трехмерного моделирования виртуальной камеры с теми же параметрами внутреннего и внешнего ориентирования.

Калибровка камеры позволяет оценить её параметры внутреннего ориентирования по изображениям сцены и известным трёхмерным координатам точек наблюдаемой сцены [21]. Задача определения параметров решается как задача оценки неизвестных параметров по наблюдениям. В качестве модели камеры используются уравнения коллинеарности:

(2)

(2)

Дополнительные параметры, описывающие нелинейные искажения принимаются в форме:

![]() (3)

(3)

![]() (4)

(4)

где

x, y, – координаты точки снимка,

X,Y,Z – трёхмерные координаты точек сцены,

ai, bi, ci, i = 1,2,3 – элементы матрицы преобразования систем координат изображения и сцены,

xp, yp, – координаты главной точки изображения,

mx, my - масштабы по x и y,

K1,K2,K3 – коэффициенты радиальной дисторсии,

P1,P2 – коэффициенты тангенциальной дисторсии.

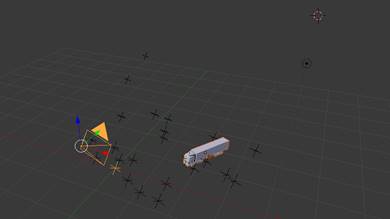

Для оценки параметров камеры необходимо знание пространственных координат точек сцены, используемых для калибровки, или масштаба объектов. Масштаб снимка определяется на основе подхода, использующего модели объекта. Предполагается, что имеется трёхмерная модель объекта (объектов), присутствующего в наблюдаемой сцене. Это позволяет сопоставить точки на изображении известным координатам такого объекта.

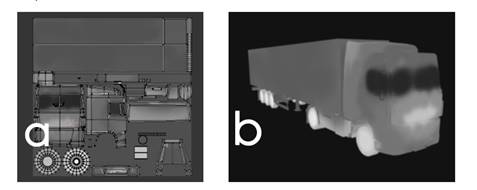

Рис. 3. Модель объекта, используемая для процедуры калибровки виртуальной камеры.

На рисунке 3 показан пример модели объекта, используемой для процедуры калибровки виртуальной камеры. В результате калибровки находятся параметры внутреннего ориентирования. Параметры внешнего ориентирования (Xi, Yi, Zi – положение и αi,ωi,χi. – угловое положение в заданной системе координат) находятся как функции дискретного времени k (номера текущего кадра).

2.6. Построение трёхмерных моделей

Построение трёхмерных полигональных моделей объектов интереса выполнялось с использованием программного обеспечения Blender. Для моделирования инфракрасного излучения использовались текстуры, имитирующие тепловое излучение объекта.

Рис. 4. Трёхмерная модель объекта интереса в среде 3D-редактора Blender: a – текстура, имитирующая тепловое излучение объекта интереса; b – трёхмерная модель с наложенной текстурой.

2.7. Прослеживание объектов с использованием алгоритма Z-поток

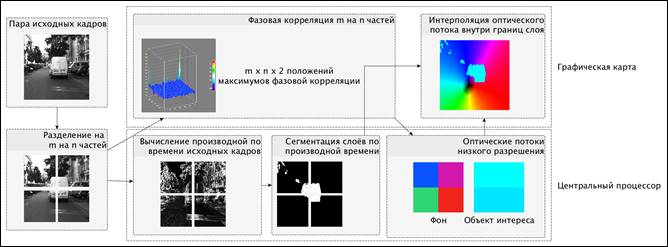

Для ускорения рутинного этапа разметки положения целевых объектов на исходных видеопоследовательностях использовался алгоритм Z-поток [5]. Данный алгоритм производит построение оптического потока – плотной карты скоростей соответствующих пикселов двух последовательных кадров – с использованием нормированной кросс-корреляции в частотной области. Полученный оптический поток соответствует межкадровым смещениям целевого объекта и используется для автоматического прослеживания объектов интереса. Для исключения влияния фона на оценку сдвига объекта используется автоматическая сегментация объекта на фон и объект интереса с использованием разреза графов [2].

Первый этап алгоритма состоит в построении оптического потока с низким разрешением. Для создания такого потока, исходные изображения разделяются на m на n частей (рис. 5).

Рис. 5. Основные этапы алгоритма Z-поток.

Для оценки векторов потока в каждой части используется метод фазовой корреляции [7]. Метод фазовой корреляции основан на свойстве сдвига преобразования Фурье. Пусть I1 (х, у), I2 (х, у) два изображения, причём I2 смещено относительно I1 на вектор (х ', у'):

![]()

![]() (5)

(5)

Тогда в соответствии со свойством сдвига преобразования Фурье:

![]()

![]() (6)

(6)

где F1 и F2 Фурье образы изображений I1 и I2. Тогда нормированный перекрёстный спектр имеет вид:

![]() (7)

(7)

Обратное преобразование Фурье R (u, v) представляет собой нормированную кросс-корреляцию изображений I1 и I2:

![]() (8)

(8)

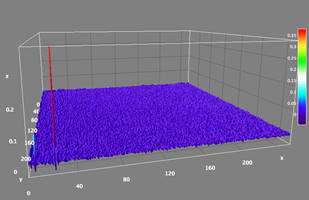

Искомый вектор сдвига (х', у') можно найти как местоположение максимума r(х, у). В случае, когда на изображениях I1 и I2 присутствует несколько движений, в r(х, у) будут видны многочисленные пики [14]. При этом возможны три случая:

1. на изображении присутствует только фон;

2. присутствует только препятствие;

3. присутствует и фон, и препятствие.

Для случаев 1 и 2 функция нормированной кросс-корреляции r будет иметь только один главный пик. Для случая 3 в r будут присутствовать два доминирующих пика (рисунок 6), и их интенсивность будет примерно пропорциональна площади областей соответствующих объектов исходного изображения. Следовательно, интенсивность пиков может быть использована для того, чтобы правильно соотнести вектор перемещения с площадью препятствия и фона, оцененной с использованием сегментации на основе разреза графов.

Рис. 6. Два пика в нормированной кросс-корреляции r, соответствующие движению фона и препятствия.

Таким образом, алгоритм Z-поток позволяет произвести точную оценку движения объекта в сложных случаях совместного движения фона и объекта.

Таким образом, разработанная методика заключается в последовательном превращении кадров видеопоследовательности видимого диапазона в кадры, имитирующие инфракрасные инфракрасный диапазон. Общий вид методики представлен в таблице 1.

Таблица 1. Методика построения модельных изображений инфракрасного диапазона

|

Методика построения модельных изображений инфракрасного диапазона 1. Разметка точек объектов интереса на первом кадре реальной видеопоследовательности видимого диапазона 2. Построение 3D-моделей объектов интереса 3. Построение текстур излучательной способности в инфракрасном диапазоне 4. Автоматическое прослеживание точек объектов интереса с помощью алгоритма Z-поток 5. Ориентирование камеры с использованием алгоритма Structure from motion (SfM) 6. Приведение гистограммы красного канала кадров видеопоследовательности видимого диапазона для получения псевдоинфракрасных фоновых текстур 7. Объединение псевдоинфракрасной фоновой текстуры и слоя 3D-объектов |

3. Обучение свёрточной нейронной сети

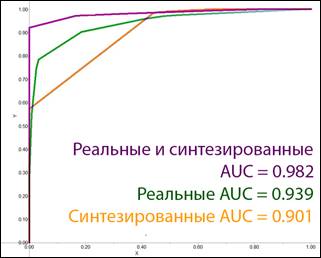

Для оценки предложенной методики синтезирования изображений инфракрасного диапазона, визуально схожих с реальными было произведено обучение свёрточной нейронной сети на трёх типах обучающих выборок. Первая выборка состояла из реальных изображений видимого и инфракрасного диапазонов. Вторая выборка состояла из реальных изображений и синтезированных изображений инфракрасного диапазона. Третья выборка являлась объединением первых двух выборок. При обучении сети на вход подавалось цветное изображение, полученное с помощью комплексирования изображений видимого и инфракрасного диапазонов. Комплексирование производилось с использованием пирамиды лапласианов [15]. Объём выборок составлял 60000 изображений. Примеры полученных псевдоинфракрасных изображений объектов интереса приведены на рисунке 7.

Рис. 7. Примеры модельных (два верхних ряда) изображений из обучающей выборки и реальных изображений (два нижних ряда) из тестовой выборки.

Для оценки качества распознавания использовалась независимые тестовые выборки объёмом в 1000 реальных изображений. Сравнение качества распознавания производилось по площади под ROC-кривой (рисунок 8) [20]. ROC-кривая (receiver-operator characteristic) или кривая ошибок – широко распространённый метод оценки качества работы бинарного алгоритма классификации. Площадь под кривой ошибок – Area Under Curve (AUC)– является обобщённой характеристикой качества классификации, не зависящей от соотношения цен ошибок. Идеальному классификатору соответствует AUC = 1. При тестировании глубокой свёрточной нейронной сети, обученной на модельных изображения, на тестовой выборке, составленной из реальных изображений, площадь под кривой была равна AUCM =0,901. Применив описанный выше критерий оценки качества моделирования, можно получить следующее значение:

![]() (9)

(9)

Анализ полученных ROC-кривых и вычисленного значения критерия визуальной адекватности показывает, что использование синтезированных изображений обеспечивает качество распознавания, сравнимое с качеством распознавания, полученным на реальных изображениях. При этом качество распознавания, полученное при обучении на выборке, включающей реальные и модельные изображения, превосходит, качество распознавания сети, обученной только на реальных изображениях. Таким образом, использование синтезированных изображений для дополнения имеющихся обучающих выборок видимого диапазона, позволяет повысить качество распознавания многоспектральных изображений.

Рис. 8. Вид ROC-кривых для различных обучающих выборок.

4. Выводы

Предложена методика синтезирования изображений инфракрасного диапазона, визуально схожих с реальными, для решения задач формирования обучающих выборок для глубоких свёрточных нейронных сетей. Методика основывается на использовании текстурированных 3D-моделей объектов интереса и построении псевдоинфракрасных фоновых текстур на основе изображений видимого диапазона.

Разработан алгоритм совмещения реальных изображений и 3D-моделей объектов, присутствующих на изображении, для формирования синтетических инфракрасных изображений. Для точного совмещения выполняется калибровка и ориентирование виртуальной инфракрасной камеры по автоматически выделенным соответствующим точкам на изображении объекта и на 3D-модели.

Предложен, реализован в программном обеспечении и исследован алгоритм прослеживания заданных объектов на видеопоследовательностях, позволяющий оперативно формировать набор изображений объекта для процедур обучения. Предложен критерий адекватности получаемых модельных изображений инфракрасного диапазона, оценивающий визуальное качество модельных изображений с точки зрения успешного обучения нейронной сети.

Проведены исследования разработанной методики для построения обучающей выборки для решения задачи обнаружения препятствий на взлётно-посадочной полосе. Результаты исследований показали, что качество синтетических инфракрасных изображений, создаваемых по разработанной методике, обеспечивает эффективное обучение сети и последующее надёжное распознавание заданных классов объектов.

Благодарности

Работа выполнена при поддержке Российского фонда фундаментальных исследований, грант РФФИ 16-38-00940 мол_а и Российского научного фонда, грант РНФ 16-11-00082.

Ссылки

1. P.F. AC 150/5220-24, Airport Foreign Object Debris (FOD) Detection Equipment / P.F. – 2009. – P. 1–18.

2. Boykov Y., Kolmogorov V. An Experimental Comparison of Min-Cut/Max-Flow Algorithms for Energy Minimization in Vision. IEEE Trans. Pattern Anal. Mach. Intell. 2004. Vol. 26. No. 9. Pp. 1124–1137.

3. Jia Deng [et al.]. ImageNet: A large-scale hierarchical image database. 2009 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops (CVPR Workshops). 2009. Pp. 248–255.

4. Kniaz V.V. A Fast Recognition Algorithm for Detection of Foreign 3D Objects on a Runway. ISPRS - International Archives of the Photogrammetry, Remote Sensing and Spatial Information Sciences. 2014. Vol. XL-3. Pp. 151–156.

5. Kniaz V.V. Real-time optical flow estimation on a GPU for a skied-steered mobile robot. SPIE Photonics Europe. 2016. Vol. 9897. Pp. 989706–989706–12.

6. Krizhevsky A., Sutskever I., Hinton G.E. Imagenet classification with deep convolutional neural networks. Advances in Neural Information Processing Systems. 2012.

7. Kuglin C.D., Hines D.C. The phase correlation image alignment method. Proceeding of IEEE International Conference on Cybernetics and Society. 1975. Pp. 163–165.

8. Ling H. [et al.]. Robust infrared vehicle tracking across target pose change using L1 regularization. IEEE. 2010. 8 p.

9. Lin T.-Y. [et al.]. Microsoft COCO: Common Objects in Context. Computer Vision ECCV. 2014: Lecture Notes in Computer Science. 2014. Vol. 8693. Pp. 740–755.

10. May C.M., Pinto N.A., Sanders J.S. Multi-spectral synthetic image generation for ground vehicle identification training. SPIE Defense + Security. SPIE, 2016. Vol. 9820. Pp. 98201A–11.

11. Patel V.M., Nasrabadi N.M., Chellappa R. Sparsity-motivated automatic target recognition. Applied Optics. 2011. Vol. 50. No. 10. Pp. 1425–1433.

12. Szegedy C. [et al.]. Going deeper with convolutions. IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2015. Pp. 1–9.

13. Weber B.A., Penn J.A. Synthetic forward-looking infrared signatures for training and testing target identification classifiers. Optical Engineering. Vol. 43. No. 6. Pp. 1414–1423.

14. Yan H., Liu J.G. Robust Phase Correlation based Motion Estimation and Its Applications. British Machine Vision Conference. British Machine Vision Association, 2008. Pp. 104.1–104.10.

15. Yushi Chen. [et al.]. Deep Learning-Based Classification of Hyperspectral Data. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing. 2014. Vol. 7. No. 6. Pp. 2094–2107.

16. Zheltov S. Method of 3d-object detection based on orthophoto difference analysis. The International Archives of Photogrammetry and Remote Sensing. Vol. XXXIII. Part B3. 2000.

17. Бусурин В.И., Князь В.В. Автоматическое обнаружение препятствий на взлётно-посадочной полосе средствами технического зрения. Труды МАИ. 2015. No. 81.

18. Гонсалес Р. Вудс Р. Цифровая обработка изображений. Техносфера. 2012.

19. Желтов С.Ю., Выголов О.В., Визильтер Ю.В. Авиационные системы улучшенного и синтезированного видения закабинного пространства. Полет. 2013. №1. C. 33-39.

20. Fawcett T., 2003. ROC graphs: notes and practical considerations for data mining researchers. Technical Report HPL-2003-4. HP Labs.

21. Knyaz V.A. Scalable photogrammetric motion capture system “mosca”: development and application, Int. Arch. Photogramm. Remote Sens. Spatial Inf. Sci., XL-5/W6, 43-49, doi:10.5194/isprsarchives-XL-5-W6-43-2015, 2015.

GENERATION OF SYNTHETIC INFRARED IMAGES AND THEIR VISUAL QUALITY ESTIMATION USING DEEP CONVOLUTIONAL NEURAL NETWORKS

Vladimir V. Kniaz, Vladimir S. Gorbatsevich, Vladimir A. Mizginov

Federal State Unitary Enterprise «State Research Institute of Aviation Systems» GosNIIAS, Moscow, Russiam Federation.

vl.kniaz@gosniias.ru, gvs@gosniias.ru, kevin5garnett-kg@yandex.ru

Abstract

In recent years deep convolutional neural networks became a powerful tool for object recognition. Accuracy of deep convolutional neural networks is comparable with the accuracy of a human operator. Convolutional networks also provide a flexible framework for hyperspectral image processing. The simultaneous usage of images that were captured using sensors of different wavelengths increases the probability of the correct classification.

To achieve a high accuracy of classification during the learning process it is required to have a large number of images in the training dataset. Training images should be captured under various conditions. A number of large image datasets (Pascal VOC, MS COCO) for training of image classification algorithms are available in the open access nowadays. However, training of image classification algorithm for classification of infrared images is more complex as large datasets of infrared images are not available in the open access.

This paper is focused on the development of a method for augmentation of images captured in the visible wavelength with synthetic infrared images. The method is based on the rendering of textured 3D-models of objects of interest and generation of pseudo-infrared background textures from a source image captured in the visible wavelength. An algorithm for registration of real images and 3D-models is presented. A dedicated algorithm for object tracking in complex environment is discussed. The proposed method was used to generate a large learning dataset for detection of foreign objects on a runway. To evaluate the quality of synthetic images a special quality measure is proposed. The measure is based on the accuracy of a deep neural network. The paper is concluded with the discussion of the accuracy of deep convolutional neural network classifier trained on the dataset that were generated using the proposed method.

Keywords: infrared images, augmented reality, object recognition, deep convolutional neural networks, foreign object detection on a runway, object tracking.

References

1. P.F. AC 150/5220-24, Airport Foreign Object Debris (FOD) Detection Equipment / P.F. – 2009. – P. 1–18.

2. Boykov Y., Kolmogorov V. An Experimental Comparison of Min-Cut/Max-Flow Algorithms for Energy Minimization in Vision. IEEE Trans. Pattern Anal. Mach. Intell. 2004. Vol. 26. No. 9. Pp. 1124–1137.

3. Jia Deng [et al.]. ImageNet: A large-scale hierarchical image database. 2009 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops (CVPR Workshops). 2009. Pp. 248–255.

4. Kniaz V.V. A Fast Recognition Algorithm for Detection of Foreign 3D Objects on a Runway. ISPRS - International Archives of the Photogrammetry, Remote Sensing and Spatial Information Sciences. 2014. Vol. XL-3. Pp. 151–156.

5. Kniaz V.V. Real-time optical flow estimation on a GPU for a skied-steered mobile robot. SPIE Photonics Europe. 2016. Vol. 9897. Pp. 989706–989706–12.

6. Krizhevsky A., Sutskever I., Hinton G.E. Imagenet classification with deep convolutional neural networks. Advances in Neural Information Processing Systems. 2012.

7. Kuglin C.D., Hines D.C. The phase correlation image alignment method. Proceeding of IEEE International Conference on Cybernetics and Society. 1975. Pp. 163–165.

8. Ling H. [et al.]. Robust infrared vehicle tracking across target pose change using L1 regularization. IEEE. 2010. 8 p.

9. Lin T.-Y. [et al.]. Microsoft COCO: Common Objects in Context. Computer Vision ECCV. 2014: Lecture Notes in Computer Science. 2014. Vol. 8693. Pp. 740–755.

10. May C.M., Pinto N.A., Sanders J.S. Multi-spectral synthetic image generation for ground vehicle identification training. SPIE Defense + Security. SPIE, 2016. Vol. 9820. Pp. 98201A–11.

11. Patel V.M., Nasrabadi N.M., Chellappa R. Sparsity-motivated automatic target recognition. Applied Optics. 2011. Vol. 50. No. 10. Pp. 1425–1433.

12. Szegedy C. [et al.]. Going deeper with convolutions. IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2015. Pp. 1–9.

13. Weber B.A., Penn J.A. Synthetic forward-looking infrared signatures for training and testing target identification classifiers. Optical Engineering. Vol. 43. No. 6. Pp. 1414–1423.

14. Yan H., Liu J.G. Robust Phase Correlation based Motion Estimation and Its Applications. British Machine Vision Conference. British Machine Vision Association, 2008. Pp. 104.1–104.10.

15. Yushi Chen. [et al.]. Deep Learning-Based Classification of Hyperspectral Data. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing. 2014. Vol. 7. No. 6. Pp. 2094–2107.

16. Zheltov S. Method of 3d-object detection based on orthophoto difference analysis. The International Archives of Photogrammetry and Remote Sensing. Vol. XXXIII. Part B3. 2000.

17. Busurin V.I., Knyaz V.V. Avtomaticheskoe obnaruzhenie prepjatstvij na vzljotno-posadochnoj polose sredstvami tehnicheskogo zrenija [Automatic detection of obstacles on the runway means vision]. Proceedings of the MAI. 2015. No. 81. [In Russian]

18. Gonzalez R. Woods R. Cifrovaja obrabotka izobrazheniĭ [Digital Image Processing]. Tehnosfera. 2012. [In Russian]

19. Zheltov S.Ju., Vygolov O.V., Vizilter Ju.V. Aviacionnye sistemy uluchshennogo i sintezirovannogo videnija zakabinnogo prostranstva [Aviation enhance and synthesized vision systems outside of spice]. Polet. 2013. No1. Pp. 33-39. [In Russian]

20. Fawcett T., 2003. ROC graphs: notes and practical considerations for data mining researchers. Technical Report HPL-2003-4. HP Labs.

21. Knyaz V.A. Scalable photogrammetric motion capture system “mosca”: development and application, Int. Arch. Photogramm. Remote Sens. Spatial Inf. Sci., XL-5/W6, 43-49, doi:10.5194/isprsarchives-XL-5-W6-43-2015, 2015.