Визуализация событий эксперимента MPD

коллайдера NICA для системы мониторинга

К. Герценбергер1, С. Мерц1, Е. Чепин2

1 Объединенный институт ядерных исследований, Дубна, Россия

2 Национальный исследовательский ядерный университет «МИФИ», Москва, Россия

gertsen@jinr.ru, sergey.merts@gmail.com, chepin@dozen.mephi.ru

Оглавление

2. Реконструкция пространственных координат частиц в событиях эксперимента

3. Параллельная реализация реконструкции точек треков частиц в событии MPD

4. Визуализация событий эксперимента MPD для системы мониторинга

Одной из задач экспериментов физики высоких энергий по столкновению частиц (или частицы с фиксированной мишенью) является визуальное представление событий проводимого эксперимента в режиме онлайн. Статья описывает реализацию данной задачи для будущего эксперимента MPD (Multi-Purpose Detector) ускорительного комплекса NICA (Nuclotron-based Ion Collider fAcility), разрабатываемого в Объединенном институте ядерных исследований (ОИЯИ) в городе Дубна. Кратко рассмотрено назначение комплекса NICA, структура многоцелевого детектора MPD для исследования горячей и плотной барионной материи, образованной при столкновении тяжелых ионов в диапазоне атомных масс A=1–197 при энергии в системе центра масс до 11 ГэВ (для Au79+). Представлен разработанный подход, реализующий быстрое восстановление пространственных координат первичных и вторичных частиц после столкновения тяжелых ионов в детекторе MPD. Особо отмечено распараллеливание наиболее затратной по времени функции – реконструкции хитов время-проекционной камеры (time projection chamber, TPC), для ускорения визуализации, а, следовательно, увеличения количества просматриваемых событий в системе мониторинга за единицу времени. Приводятся времена и коэффициенты ускорения обработки для средней и малой множественности моделированных данных. Проведено аналитическое моделирование выполнения параллельной реконструкции пространственных координат частиц для большего числа процессоров, предложена структура параллельной аппаратной платформы для выборочного мониторинга событий. Рассмотрена реализованная система визуализации геометрии MPD и событий столкновения частиц в многоцелевом детекторе, которая входит в состав разрабатываемого программного обеспечения эксперимента MPDRoot. Приведен пример графического представления геометрии детектора MPD и реконструированных точек треков для центрального события столкновения частиц Au+Au.

Ключевые слова: обработка физических данных, кластеризация, визуализация, мониторинг, многопоточность программной реализации, аналитическая модель, MPD.

Изучение экстремально горячей и плотной ядерной материи является актуальной задачей современной физики. Данная среда представляет особый интерес в связи с возможностью обнаружить новое состояние вещества – кварк-глюонную плазму, являющуюся предметом исследования современных экспериментов физики высоких энергий [1], существование которой предсказано современной теорией сильного взаимодействия – квантовой хромодинамикой. Изучая свойства кварк-глюонной плазмы можно исследовать наиболее фундаментальные проблемы современной физики: уравнения состояния ядерной материи при высоких плотностях, свойства фазового перехода в состояние деконфаймента, восстановление киральной симметрии, свойства кварк-адронной смешанной фазы и наличие критической точки на фазовой диаграмме [2].

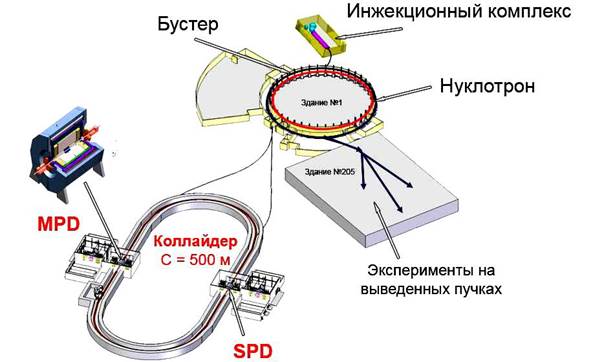

Согласно принятой программе Объединенного института ядерных исследований одной из приоритетных задач на следующие годы является создание ускорительного комплекса для исследования столкновений тяжелых ионов с высокой светимостью и современного многофункционального детектора. В рамках этой программы предусмотрено создание на базе существующего Нуклотрона коллайдера NICA для столкновения ионов при энергиях взаимодействия в системе центра масс 4 − 11 ГэВ и протонов – 4 − 26 ГэВ. На рисунке 1 приведена схема строящегося ускорительного комплекса NICA в ОИЯИ.

Рис. 1. Проект ускорительного-накопительного комплекса NICA

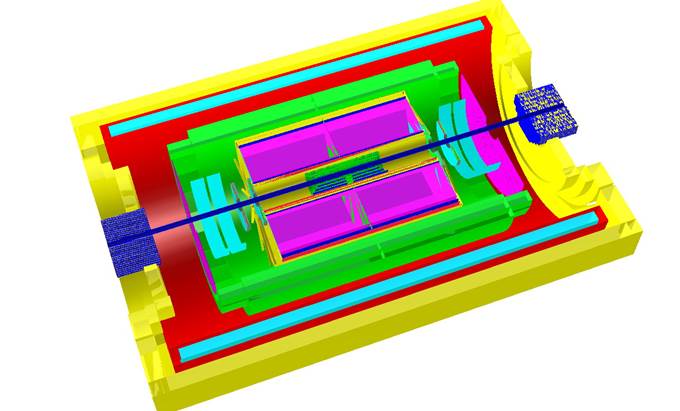

Для изучения свойств горячей и плотной ядерной материи, образованной при соударениях тяжелых ионов, исследования фазовых переходов, смешанной адронной и кварк-глюонной фазы, и различных эффектов в физических процессах используется многоцелевой детектор MPD, который будет находиться в одном из двух мест встречи пучков в коллайдере NICA.

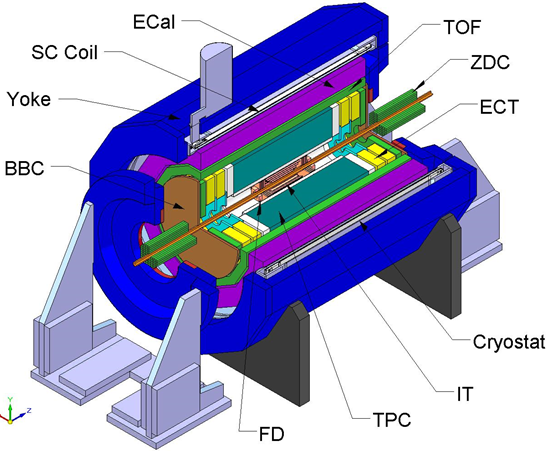

В центральном столкновении (при прицельном параметре меньшем 3 фм) тяжелых ионов золото – золото (Au + Au), которые предполагается использовать в эксперименте, при энергиях NICA образуется до 1000 заряженных частиц. Кроме того, помимо большой множественности событий, необходимо учитывать высокую скорость набора событий в будущей установке, которая будет составлять до 6 кГц. Очевидно, что для полноценного изучения такой сильновзаимодействующей материи разрабатываемый детектор должен эффективно идентифицировать продукты соударения ядер и измерять их параметры. В связи с этим, многоцелевой детектор MPD состоит из набора, дополняющих друг друга, детекторов различного типа. Концептуальная схема MPD представлена на рисунке 2.

Рис. 2. Схема многоцелевого детектора MPD коллайдера NICA

Основным детектором для восстановления треков первичных и вторичных частиц является время-проекционная дрейфовая камера TPC. Внутренняя трековая система (ITS) строится на основе кремниевых полупроводниковых детекторов. Времяпролетный детектор TOF, расположенный вокруг камеры TPC, служит для идентификации заряженных частиц с импульсом до 2 ГэВ/с. Основное назначение электромагнитного калориметра – идентификация электронов и фотонов и измерение их энергии. Торцевые трековые системы ECT расширяют диапазон регистрации частиц в передней области, где эффективность время-проекционной камеры низка. Для идентификации адронов с большой псевдобыстротой предназначены калориметры ZDC.

Задачей детектора MPD будет обработка столкновений тяжелых ионов четыре – шесть месяцев в году, начиная с момента запуска. Предполагается, что при беспрерывной работе в сеансе и скорости счета 6 кГц будет набрано около 19 миллиардов событий. Очевидно, что при таком потоке данных необходимо использовать систему визуального мониторинга выборочных событий, происходящих в многоцелевом детекторе, на компьютерной ферме, работающей в онлайн режиме с MPD. Визуализация событий эксперимента может быть предназначена как для использования экспертами на ранней стадии проектирования детектора, отладки модели, реконструкции данных и анализа алгоритмов или для контроля и визуальной отладки текущих событий, так и для пользователей для лучшего понимания состава детекторов и структуры событий, а также для демонстрации и презентации работ. Визуальный мониторинг физических процессов и данных в этом случае крайне актуален, например, для наглядной оценки множественности текущих событий, которая напрямую зависит от прицельного параметра столкновения частиц. Разрабатываемая система должна быстро показывать как точки треков в событиях столкновения ионов, так и геометрию детекторов, регистрирующих эти столкновения.

Метод научной визуализации широко используется в настоящее время во многих экспериментах. Суть этого метода заключается в том, что исходным анализируемым данным при помощи компьютера ставится в соответствие их некоторая статическая или динамическая графическая интерпретация, которая визуально анализируется, а результаты анализа этой графической интерпретации затем истолковываются по отношению к исходным данным [3]. Системы визуализации крайне актуальны и применяются сейчас во многих крупных экспериментах физики высоких энергий, таких как, например: CMS, ALICE и ATLAS [4–6]. В перечисленных примерах также используется коллайдер для столкновения частиц, в том числе, ионов тяжелых металлов, но при существенно большей энергии. Ниже кратко приведена информация о системах графического представления событий в этих экспериментах и применявшихся инструментах.

Система визуализации событий в детекторе CMS реализована на основе программной среды IGUANA (Interactive Graphics for User ANAlysis), позволяющей графически представить события идущего эксперимента. Она имеет ключевое значение в системе контроля качества данных детектора, фильтрации огромного количества информации и наглядного представления характерных особенностей как инженерам смен в контрольных комнатах в режиме онлайн, так и пользователям коллаборации при обработке и анализе полученной информации. Используемое программное обеспечение обеспечивает пособытийную визуальную интерпретацию данных CMS, что помогло настроить работу составляющих детекторов [7].

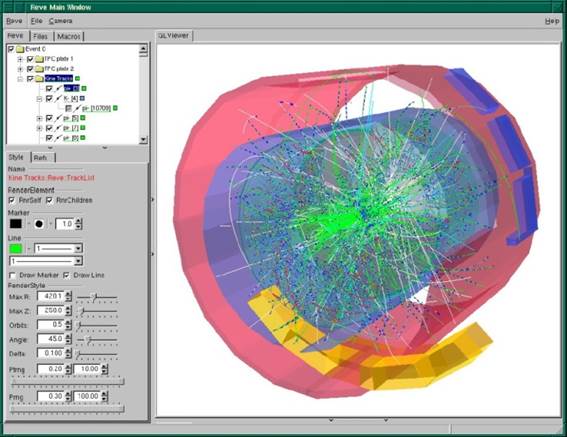

В эксперименте ALICE используется система визуализации AliEVE, основанная на GUI программной среды ROOT, ее классах для работы с двумерными и трехмерными геометрическими объектами. Коллаборацией были разработаны собственные базовые классы для графического представления и управления объектами физики высоких энергий, которые затем сформировали новый пакет EVE в среде ROOT для использования в других экспериментах. Система AliEVE используется в установке ALICE для визуализации событий, происходящих в детекторе, в триггере высокого уровня в режиме онлайн и при последующей обработке полученных данных. В ней графически представлены кластеры хитов, треки и упрощенная геометрия детектора (рисунок 3). Система визуализации играет важную роль на этапе калибровки детектора, при оценке его загруженности и уровня шумов в эксперименте ALICE [8].

Рис. 3. Визуализация события эксперимента ALICE в системе AliEVE

В эксперименте ATLAS была разработана своя система визуализации, получившая название Atlantis, на языке программирования Java (с использованием программных интерфейсов Java2D и Swing) на основе среды DALI для установки ALEPH. Главной целью системы Atlantis является обеспечение простого, быстрого графического представления и физического понимания сложных событий. В среде реализован набор двумерных и трехмерных проекций данных, позволяющих пользователям быстро понять и визуально оценить параметры событий столкновения частиц, а также проверить правильность шагов при реконструкции (кластеризации, трекинге) и связи между физическими объектами, например, соответствие хитов трекам частиц [9].

Для поддержки эксперимента MPD разрабатывается программная среда MPDRoot, служащая, как для моделирования и изучения свойств работы детектора, так и для реконструкции экспериментальных или (на сегодняшний день) смоделированных данных и последующего физического анализа событий столкновения тяжелых ионов, регистрируемых многоцелевым детектором на установке NICA. Среда MPDRoot создается на языке программирования C++ на базе программного обеспечения ROOT [10] и FairRoot [11] эксперимента FAIR института GSI в Германии.

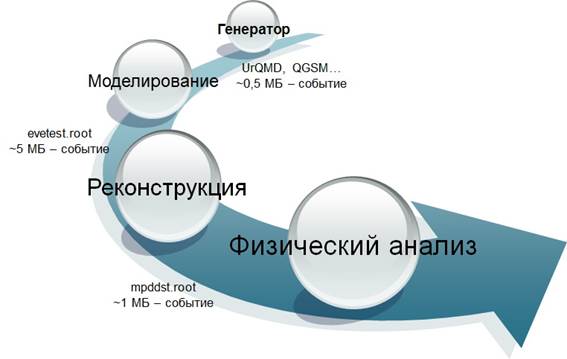

Основными этапами работы MPDRoot являются генерация начальных данных об образованных частицах событий, моделирование прохождения частиц через детекторы при помощи пакетов транспорта частиц, таких как, например, GEANT3 [12], реконструкция информации о частицах, зарегистрированных детекторами, их треках и параметров, и дальнейшее проведение физического анализа реконструированных данных. Данные, полученные при помощи генераторов событий, таких как, например, UrQMD [13] или LAQGSM [14], содержат полную информацию об образованных частицах: тип частицы, ее импульс и другие кинематические характеристики. Данные событий эксперимента хранятся в ROOT файлах в иерархическом древовидном виде. Последовательность основных этапов программного обеспечения MPDRoot схематично представлена на рисунке 4.

Рис. 4. Последовательность этапов выполнения макросов MPDRoot

Интеграция системы визуализации в среду MPDRoot позволяет объединить разные этапы обработки данных событий столкновения частиц в детекторе MPD в одной программной оболочке с визуальным представлением этих событий для оценки и проверки правильности работы алгоритмов реконструкции и анализа. Кроме того, это позволяет учитывать в системе визуализации изменение текущей геометрии MPD и поэтапное добавление в структуру многоцелевого детектора поддетекторов.

Во втором разделе данной статьи описывается реализация в среде MPDRoot быстрого восстановления пространственных координат первичных и вторичных частиц в событиях столкновения тяжелых ионов для дальнейшего графического представления в системе мониторинга идущего эксперимента MPD. В третьем разделе представлена разработанная система визуализации этих реконструированных данных в MPDRoot при помощи пакета EVE [15].

2. Реконструкция пространственных координат частиц в событиях эксперимента

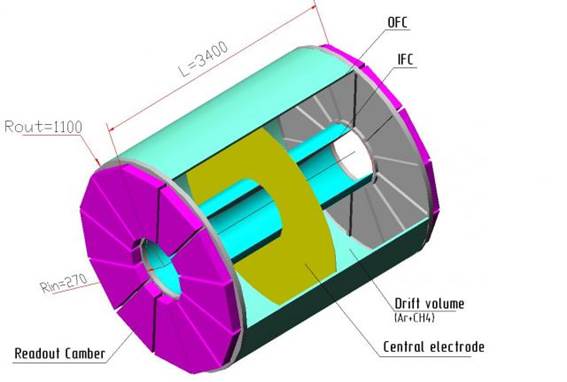

Время-проекционная камера является основным трековым детектором эксперимента MPD в центральной области псевдобыстрот, при помощи нее производится измерение импульса заряженных частиц, реконструируются треки, а также измеряются потери энергии dE/dx для идентификации заряженных адронов и лептонов. Общая схема время-проекционной камеры представлена на рисунке 5.

Рис. 5. Схема время-проекционной камеры TPC детектора MPD

Активный объем TPC, заполненный газовой смесью аргона и метана, представлен двумя коаксиальными цилиндрическими поверхностями со встроенными в них с обоих торцов системами считывания на основе многопроволочной пропорциональной камеры MWPC. Однородное электрическое поле в активном объеме, необходимое для дрейфа электронов к торцевым считывающим плоскостям, формируется при помощи центрального электрода и концентрических полевых цилиндров. Длина TPC составляет 340 сантиметров, внешний радиус – 110 сантиметров, внутренний радиус – 27 сантиметров. Считывающие плоскости с каждой стороны состоят из 12 трапецеидальных секторов MWPC, покрывая площадь около 8 квадратных метров. Каждый сектор занимает 30° по азимуту. Электроны, образующиеся при ионизации газа заряженными частицами, дрейфуют к падовым плоскостям считывающих камер. Пады располагаются в рядах (падовых строках), направленных азимутально перпендикулярно оси сектора. Каждый сектор содержит 51 падовую строку, при этом 21 строка состоит из маленьких падов размером 12×4 мм, а следующие 30 строк – из больших падов размером 18×5 мм. Количество падов в падовой строке разное в зависимости от ее длины, при этом общее количество падов во время-проекционной камере составляет примерно 110 000.

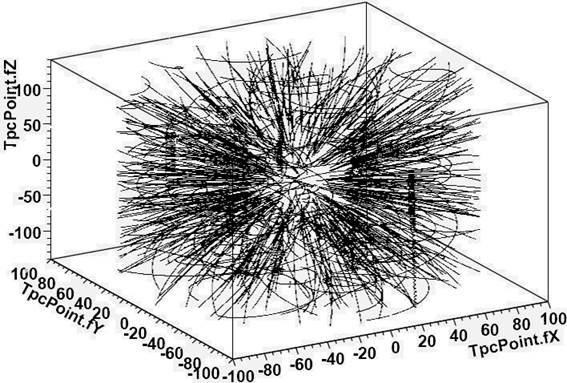

Как уже было отмечено выше, на этапе разработки ускорительно-накопительного комплекса NICA при реконструкции точек и треков частиц в детекторе MPD используются моделированные данные. На рисунке 6 представлены треки заряженных частиц в детекторе TPC, смоделированные пакетом GEANT3, в примере для сталкивающихся частиц Au+Au при энергии в системе центра масс 9 ГэВ.

Рис. 6. Треки заряженных частиц смоделированного события в TPC

В программной среде MPDRoot реализовано подробное моделирование работы детектора TPC: после работы пакета транспорта частиц (Geant3, Geant4, Fluka [16]) через время-проекционную камеру проводится ряд дополнительных шагов, приближающих симуляцию к реальной физической картине. Для этого от каждой полученной Монте-Карло точки треков частиц в TPC моделируется дрейф электронов, образующихся при пролете частицы в активной области TPC, до падовых плоскостей камеры с учетом диффузии, дисторсии и поглощения электронов ионизации. Сформированные электронные облака при достижении считывающих камер MWPC наводят заряды на соответствующих смежных падах. Распределение наведенных зарядов характеризует функцию откликов падов. После чего производится предварительное усиление сигнала и отклик падов с дальнейшей оцифровкой полученного сигнала.

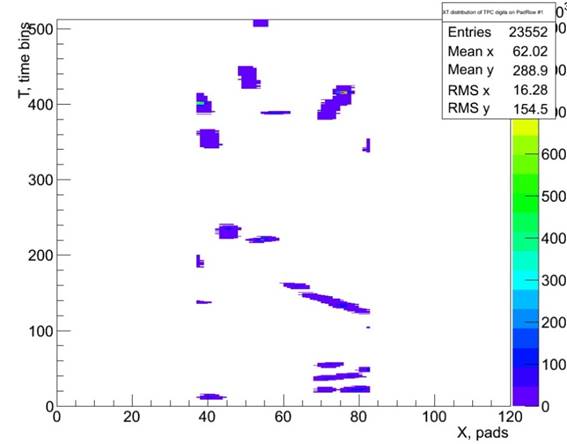

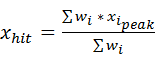

Для восстановления пространственных координат частиц во время-проекционной камере на первом этапе производится кластеризация наведенных на падах сигналов в пространстве пад-время для дальнейшего восстановления по ним хитов и далее точек треков заряженных частиц. Полученные цифровые сигналы с падовой плоскости TPC (экземпляры разработанного класса MpdTpcDigit), прежде всего, сортируются по номеру падовой строки. При кластеризации осуществляется проход по всем секторам, падовым строкам и, соответственно, падам время-проекционной камеры, в кластеры собираются все смежные отклики в пространстве пад-время. Пример кластеризации для первой падовой строки в детекторе TPC в пространстве пад-время для события MPD приведен на рисунке 7, где по оси X представлен номер пада в падовой строке, а по оси Y – время (временной интервал, бин) отклика пада при наведении на него заряда от электронного облака.

Рис. 7. Кластеризация откликов падов TPC в пространстве пад-время

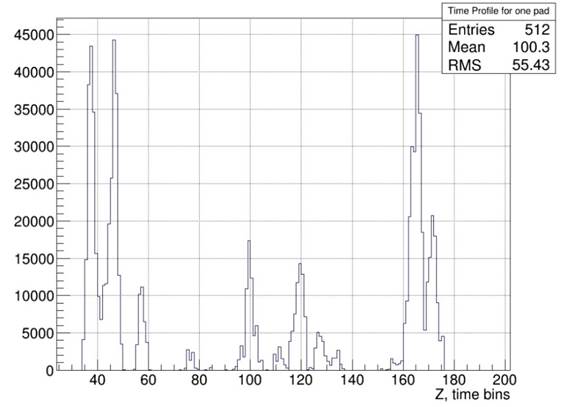

В силу разных причин кластеры от разных треков могут перекрываться, поэтому на втором этапе происходит выделение отдельных хитов во всех найденных кластерах. Для этого производится поиск пиков по времени на отдельном паде в полученном цифровом сигнале. Пик, в данном случае, определяется упорядоченным по времени набором значений цифрового сигнала с данного пада. Пример временного профиля сигнала с одного пада TPC в событии приведен на рисунке 8, где по оси X отложен временной бин события, а по оси Y – заряд на этом паде в электронах.

Рис. 8. Пример профиля сигнала на паде время-проекционной камеры

Отдельные пики во временном ряду аппроксимируются функцией Гаусса, что позволяет получить координату вершины пика и его среднеквадратичное отклонение. После определения всех пиков цифрового сигнала по времени и их параметров восстанавливаются хиты для каждого кластера путем группировки пиков смежных падов, имеющих пик в предшествующий, тот же или последующий временной момент, то есть соседних пиков по горизонтали, вертикали или диагонали в двумерном пространстве пад-время. При помощи алгоритма взвешенного среднего вычисляется центр тяжести амплитуд цифровых сигналов смежных пиков для каждой найденной группы в пространстве пад-время. Центр тяжести всех пиков группы и будет являться в нашем случае восстановленным хитом, соответствующим точке трека частицы, координата и временной бин которого определяются согласно следующим формулам:

, (1)

, (1)

, (2)

, (2)

где wi – полученный заряд для данного пика на паде, ti – время данного пика в пространстве пад-время, а xi – номер пада в строке. На рисунке 9 приведены восстановленные хиты в двумерном пространстве пад-время для примера, показанного на рисунке 7.

Рис. 9. Восстановленные хиты в первой падовой строке TPC

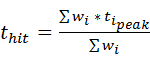

Зная скорость дрейфа электронов в детекторе TPC и временной бин найденного хита, рассчитываемого по формуле (2), вычисляется координата z восстанавливаемой точки в активном объеме время-проекционной камеры, которая затем выводится в системе мониторинга на экран. Координата y этой точки определяется номером падовой строки, а координата x вычисляется по формуле (1). На рисунке 10 приведен пример восстановленных трехмерных точек (класс MpdTpcHit) треков частиц во время-проекционной камере для смоделированного события в среде MPDRoot.

Рис. 10. Восстановленные трехмерные точки треков частиц в детекторе TPC

Таким образом, общий алгоритм реконструкции пространственных координат частиц во время-проекционной камере для события MPD состоит из следующих основных этапов:

· Кластеризация цифровых сигналов, полученных с падов время-проекционной камеры, в пространстве пад-время.

· Поиск и аппроксимация функцией Гаусса (определение параметров гауссиана) пиков по времени на отдельных падах в полученном цифровом сигнале.

· Восстановление хитов для каждого кластера путем группировки пиков смежных падов и вычисления центра тяжести амплитуд пиков для каждой сформированной группы в пространстве пад-время.

· Вычисление (восстановление) трехмерных координат (x, y, z) точек треков частиц в активном объеме детектора TPC, соответствующих найденным хитам.

3. Параллельная реализация реконструкции точек треков частиц в событии MPD

Восстановление пространственных координат частиц для смоделированных событий MPD показало, что основное время операции занимает кластеризация сигналов в пространстве пад-время и нахождение хита, соответствующего точке трека заряженной частицы во время-проекционной камере. Время реконструкции в зависимости от множественности события составило от одной до нескольких секунд. Очевидно, что для системы мониторинга время восстановления пространственных координат частиц играет ключевую роль. Малое время обработки позволяет оперативно реагировать на изменение ситуации при столкновении тяжелых ионов в многоцелевом детекторе. С учетом большой частоты событий эксперимента MPD время восстановления пространственных координат частиц в несколько секунд является неприемлемым. Использование параллельных алгоритмов обработки данных совместно с производительной параллельной аппаратной платформой способно существенно повысить эффективность решения задачи, поэтому минимизация времени нахождения хитов в детекторе TPC проводилась путем распараллеливания данной операции.

Разработанный параллельный режим реконструкции пространственных координат частиц в событии MPD основывается на независимости поиска кластеров в пространстве пад-время и восстановления хитов в секторах и падовых строках время-проекционной камеры, что позволяет одновременно проводить вычисления для различных секторов и падовых строк детектора TPC. Для распараллеливания использовался инструмент OpenMP [17], реализующий параллельную обработку при помощи многопоточности для систем с общей памятью. В распараллеливаемые фрагменты программного кода были добавлены специализированные директивы стандарта OpenMP, определена область видимости и регламентировано использование переменных выбранных фрагментов для одновременно выполняющихся потоков, установлены точки синхронизации потоков и выполнен ряд других вспомогательных действий.

При реализации параллельного восстановления пространственных координат частиц были модифицированы классы программной среды MPDRoot, определены распараллеливаемые циклы для параллельного поиска кластеров в цифровых сигналах на падах TPC и вычисления параметров хитов в многопоточном режиме. При параллельной реконструкции для доступа разных потоков к разделяемым данным были установлены требуемые критические секции, которые несколько снижают достигаемое ускорение на параллельной архитектуре. Реализованный метод распараллеливания предназначен для систем с общей памятью, таких как: многопроцессорные и многоядерные компьютеры. Реконструкция может выполняться как в последовательном, так и параллельном режиме. Для того чтобы поиск кластеров и выделение хитов проводились параллельно на разных секторах и падовых строках, компиляция программного обеспечения MPDRoot осуществляется с флагом –fopenmp. Корректность параллельной реконструкции точек треков в событии MPD проверяется путем побитового сравнения результирующих файлов в последовательном и параллельном режиме обработки.

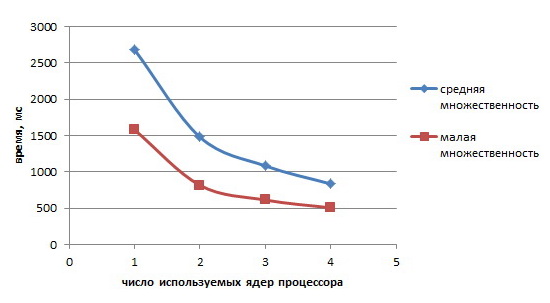

На рисунке 11 представлена зависимость времени реконструкции пространственных координат частиц от количества используемых ядер на машине с 4-х ядерным процессором Intel Core 2 Q9450 для смоделированных событий столкновения Au+Au в детекторе MPD со средней и малой множественностью при энергии в системе центра масс 9 ГэВ. Для моделирования использовался генератор событий UrQMD, а транспорт частиц осуществлялся пакетом GEANT3.

Рис. 11. Зависимость времени реконструкции от числа используемых ядер процессора

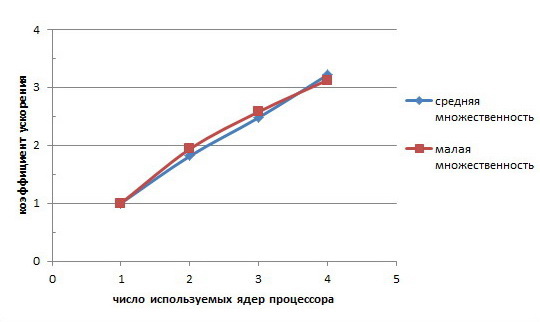

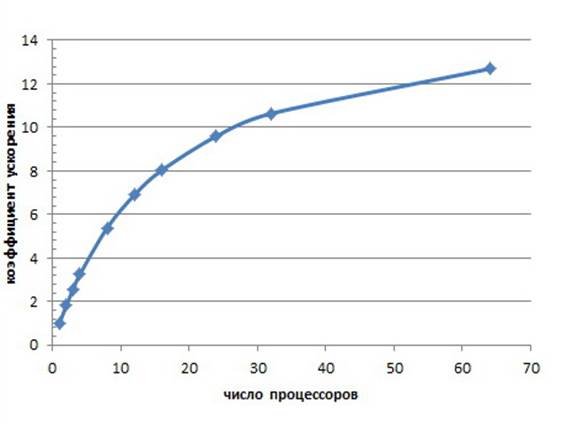

Для полученных времен обработки был рассчитан коэффициент ускорения и построена зависимость ускорения от числа используемых ядер процессора, представленная на рисунке 12, которая, как показывает график, близка к линейной. Ускорение восстановления пространственных координат частиц на 4 ядрах процессора достигает 3.2, сокращая время обработки до 500 и 800 миллисекунд для малой и средней множественности соответственно.

Рис. 12. Ускорение реконструкции пространственных координат частиц

На данном этапе важно оценить будет ли разработанная параллельная реконструкция масштабируема, то есть также эффективно выполняться на десятках или даже сотнях процессоров планируемой компьютерной фермы для выборочного онлайн мониторинга событий эксперимента MPD. Для предсказания производительности более крупной параллельной системы целесообразно использовать математическое моделирование [18]: аналитическую или имитационную модель. Такой метод оценки дает возможность исследовать ускорение и масштабируемость для разных параметров аппаратной части, например, количества процессоров или скорости чтения (записи) жестких дисков. По полученным модельным характеристикам принимается решение о выборе параметров планируемой системы.

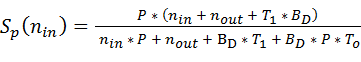

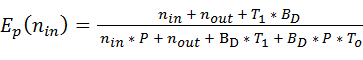

Для оценки коэффициента ускорения и эффективности разработанного параллельного алгоритма реконструкции пространственных координат частиц использовалась аналитическая модель, представленная в статье [19], основными элементами которой являются аппаратные компоненты многопроцессорной системы, их технические характеристики и алгоритм параллельной обработки. Так как восстановление хитов для различных секторов и падовых строк время-проекционной камеры проводится независимо, реализованная реконструкция относится к параллельной алгоритмической структуре – точечному алгоритму [20], соответствующему независимому по данным параллелизму. Распараллеливание таких операций сводится к распределению порций данных по процессорам с их независимой последующей обработкой. Согласно аналитической модели точечного параллельного алгоритма для систем с общей памятью коэффициент ускорения и эффективности определяются следующими формулами, которые были уточнены временем не распараллеливаемой части программного кода:

, (3)

, (3)

, (4)

, (4)

где P – количество логических процессоров (ядер) многопроцессорной системы, nin – объём обрабатываемых данных (в данном случае, сигналов, пришедших с падов камеры TPC) в байтах, nout – объём данных результата (восстановленных хитов) в байтах, BD – средняя скорость чтения/записи данных (в МБ/с), To – время не распараллеливаемой части реконструкции (объединение найденных хитов в общий массив), а T1 – время последовательной обработки данных на подобной однопроцессорной системе. Так как входные и выходные массивы данных реконструкции пространственных координат частиц хранятся в оперативной памяти, то параметр BD соответствует средней скорости чтения/записи оперативной памяти. На рисунке 13 приведен график зависимости прогнозируемого (модельного) коэффициента ускорения от количества процессоров согласно формуле (3) для параметров системы вышеприведенного примера смоделированного события со средней множественностью: nin = 61 МБ, nout = 1 МБ, BD = 970 МБ/с (измерено инструментом AIDA64[21]), To = 0.1 с, T1 = 2.5 с.

Рис. 13. Зависимость модельного ускорения реконструкции от числа процессоров

Максимальное отклонение полученных модельных значений ускорения реконструкции точек от практических значений примера (представленных на рисунке 12) составило 7 процентов, что подтверждает хорошую согласованность модели с практикой. График показывает, что распараллеливание больше чем на 8–16 процессорах нецелесообразно, так как эффективность использования процессоров, рассчитываемая по формуле (4), в таком случае довольно мала (на 16 процессорах падает ниже 0.5). Таким образом, при заданных выше параметрах компьютерной фермы онлайн мониторинга событий эксперимента MPD желательно выбирать 8–16 ядерные машины для многопоточного распараллеливания реконструкции пространственных координат частиц события на отдельной машине, а выборочный поток событий распределять и независимо обрабатывать на разных машинах вычислительной фермы.

Как уже было отмечено, восстановленные точки треков частиц в событиях MPD выводятся далее в системе мониторинга для визуального контроля эксперимента. В следующем разделе представлена разработанная в среде MPDRoot система визуализации полученных в результате быстрой реконструкции данных.

4. Визуализация событий эксперимента MPD для системы мониторинга

Как уже было отмечено, графическое представление событий, происходящих в детекторе, является неотъемлемой частью экспериментов по столкновению частиц в физике высоких энергий. Для визуализации событий целесообразно использовать специализированные инструменты, основанные на графических пакетах, использующих аппаратные возможности современных видеокарт для быстрого вывода информации на дисплей, такие как, например, OpenGL.

Программная оболочка ROOT в пакете TGeo содержит набор классов, предназначенных для создания и отображения геометрии детекторов и треков частиц при помощи класса TGeoPainer. Для исследования рабочих характеристик многоцелевого детектора MPD в среде MPDRoot были разработаны подпрограммы для генерации геометрии всех составляющих детекторов в специальном формате, который затем используется средой ROOT, главным образом, классом TGeoManager. Класс TGeoManager предназначен для работы со стандартными трехмерными геометрическими фигурами, объемами, материалами и множеством других геометрических объектов и функций. Разработанная геометрия детекторов, составляющих MPD, переводится в соответствующую иерархию экземпляров классов геометрических фигур TGeoShape, их матрицы преобразования и другую вспомогательную графическую информацию, которая сохраняется макросами MPDRoot в результирующих ROOT файлах. На данном этапе также была разработана база данных на СУБД PostgreSQL для хранения информации о геометрии детекторов эксперимента MPD.

В программной среде MPDRoot реализована визуализация геометрии детекторов, описанной при моделировании. Графический вывод на экран многоцелевого детектора MPD (с сечением плоскостью) представлен на рисунке 14.

Рис. 14. Визуализация геометрии многоцелевого детектора в среде MPDRoot

Визуализация геометрии детекторов и событий в MPDRoot базируется на высокоуровневой графической библиотеке EVE (Event Visualization Environment) программной среды ROOT, разработанной коллаборацией ALICE. Пакет EVE использует ROOT GUI и OpenGL для отображения трехмерных объектов и их двумерных проекций. Применение библиотеки OpenGL позволяет быстро обновить графическое представление информации при выводе и изменении физических объектов. Пакет дает возможность пользователю выбирать и подсвечивать отдельные элементы, настраивать их параметры, показывать различные проекции. Классы EVE предназначены, прежде всего, для создания и управления объектами визуализации данных в событиях экспериментов физики высоких энергий, такими как: необработанные данные, хиты, кластеры, треки частиц. Для графического представления физических объектов в EVE используется набор специальных классов, например: для хитов и кластеров – TEvePointSet и TEvePointSetArray, траекторий частиц – TEveTrack и TEveTrackList.

Изначально пакет EVE создавался для визуализации событий эксперимента ALICE, тем не менее, эксперименты физики высоких энергий имеют существенное сходство в объектах представления и функциональности, что позволяет настроить и использовать библиотеку EVE для других экспериментов, поэтому она была интегрирована в программную среду ROOT. Сегодня Event Visualization Environment успешно используется в ряде крупных физических проектов. Применение пакета EVE позволило настроить отображение восстановленных пространственных координат частиц и треков эксперимента MPD аналогично разработанным примерам данного инструмента.

Геометрия всех детекторов, составляющих установку MPD, передается в специальном формате программному пакету EVE для визуализации. В библиотеке присутствуют средства как для отображения траекторий частиц, так и трехмерных точек в среде. Для визуализации реконструированных точек треков частиц в событиях MPD были разработаны соответствующие классы, предназначенные для использования с пакетом EVE в отдельном макросе MPDRoot, такие как, например, класс MpdTpcHit. Восстановленные точки передаются классам-менеджерам данных, которые и отображают их в трехмерном пространстве в детекторе MPD.

Разработанный макрос визуализации MPDRoot считывает геометрию детекторов и смоделированные данные событий MPD из сгенерированных ROOT файлов, реконструирует пространственные координаты частиц, так как представлено в предыдущих разделах, и выводит все физические объекты на экран при помощи пакета EVE. Макрос отделен от классов моделирования, реконструкции и физического анализа MPDRoot и не зависит от специфики работы программного обеспечения эксперимента. Вывод реконструированных трехмерных точек треков частиц осуществляется путем использования класса TEvePointSet для полученного набора. Пользователь может выбрать, в каком режиме проводить отображение восстановленных данных событий и геометрии многоцелевого детектора: при помощи ROOT GUI или OpenGL. В макросе визуализации событий MPDRoot были установлены все необходимые вспомогательные параметры отображения физических объектов, в том числе их цвета и положение, так что пользователю не нужно знать функции и структуру пакета EVE или проводить какую-либо настройку.

На рисунке 15 представлена визуализация геометрии детектора

MPD и реконструированных точек треков (точки рисуются

черным цветом) центрального события столкновения частиц Au+Au при энергии ![]() ГэВ, смоделированного генератором UrQMD, Транспорт частиц через элементы детекторов

осуществлялся при помощи пакета GEANT3. Время быстрой

реконструкции пространственных координат частиц составило 723 миллисекунды на

четырех ядрах процессора Intel Core 2 Q9450. Из рисунка видно, что,

в связи с большим количеством точек, регистрируемых время-проекционной камерой,

восстановление пространственных координат достаточно для визуальной оценки

контролируемого события, и полноценной реконструкции треков частиц для системы

мониторинга не требуется.

ГэВ, смоделированного генератором UrQMD, Транспорт частиц через элементы детекторов

осуществлялся при помощи пакета GEANT3. Время быстрой

реконструкции пространственных координат частиц составило 723 миллисекунды на

четырех ядрах процессора Intel Core 2 Q9450. Из рисунка видно, что,

в связи с большим количеством точек, регистрируемых время-проекционной камерой,

восстановление пространственных координат достаточно для визуальной оценки

контролируемого события, и полноценной реконструкции треков частиц для системы

мониторинга не требуется.

Рис. 15. Визуализация центрального события в многоцелевом детекторе MPD

Стоит отметить, что время визуализации событий MPD также включает время вывода на экран геометрии детекторов и восстановленных точек треков частиц для системы мониторинга. Однако собственно отображение реконструированных данных производится при помощи развивающегося пакета EVE, оптимизацией которого занимается профессиональная команда разработчиков программной среды ROOT.

Таким образом, для будущего эксперимента MPD на коллайдере NICA в программной среде MPDRoot были разработаны и реализованы алгоритмы реконструкции пространственных координат частиц в событиях столкновения тяжелых ионов. Основным трековым детектором эксперимента является время-проекционная камера, поэтому основной акцент в статье был сделан на детектор TPC. Для проверки работы алгоритмов было реализовано подробное моделирование событий в камере TPC. Разработанная кластеризация сигналов на падовой плоскости и определение хитов (координат, временных меток и заряда) во время-проекционной камере занимали достаточно большое время, поэтому операция восстановления пространственных координат частиц была распараллелена при помощи инструмента OpenMP для многопроцессорных и многоядерных машин. Параллельный режим работы позволил достигнуть приемлемых времен обработки для системы мониторинга.

Разработана система визуализации событий эксперимента MPD, которая выводит геометрию всех составляющих детекторов и реконструированные точки треков частиц при помощи пакета EVE программной среды ROOT. Для графического представления полученных физических данных создан макрос, который отделен от работы комплекса MPDRoot и исполняется независимо. Геометрия детектора MPD передается в специальном формате geo-файлов классу TGeoManager, который записывает ее в файл среды ROOT. Для визуализации точек треков частиц были разработаны специальные классы, которые передаются пакету EVE для графического отображения. Реализованная система позволит визуально контролировать ход событий эксперимента и оперативно реагировать на изменения в событиях столкновения тяжелых ионов в многоцелевом детекторе.

В настоящее время также проводится анализ альтернативных пакетов для визуализации реконструированных физических данных и геометрии детекторов с последующей доработкой для использования современных графических процессоров и специализированных сред программирования CUDA (для видеокарт компании NVIDIA) или OpenCL (для видеокарт различных производителей). На сегодняшний день в программную среду MPDRoot уже были добавлены и протестированы классы интеграции пакета CUDA для выполнения обработки на графических процессорах видеокарт NVIDIA так, что функции CUDA могут вызываться напрямую из макросов MPDRoot или исполняемого кода, а их компиляция производится вместе со всеми файлами в составе пакета MPDRoot.

1. Blaizot J. The Quark-Gluon Plasma from SPS to RHIC to LHC. QNP–2012. URL: http://qnp2012.sciencesconf.org/conference/qnp2012/Blaizot.pdf

2. MPD Collaboration. The MultiPurpose Detector – MPD. Conceptual Design Report. JINR, 2012. 259 p.

3. Стриханов М. Н., Дегтяренко Н. Н., Пилюгин В. В., Маликова Е. Е., Матвеева Н. А., Пасько А. А., Аджиев В. Д. Опыт компьютерной визуализации наноструктур в НИЯУ МИФИ // Научная визуализация. Т. 1, № 1. 2009. C. 1–18. URL: http://sv-journal.com/2009-1/01.php?lang=en

4. CERN. Compact Muon Solenoid experiment at CERN’s LHC. URL: http://cms.web.cern.ch

5. CERN. A Large Ion Collider Experiment. URL: http://aliceinfo.cern.ch/Public/Welcome.html

6. CERN. ATLAS experiment. URL: http://atlas.ch

7. Osborne1 I., Alverson G., Eulisse G. and other. CMS Event Display and Data Quality Monitoring at LHC Start-up // Journal of Physics: Conference Series. Vol. 119. 2008. 7 p.

8. Tadel M. Raw-data display and visual reconstruction validation in ALICE // Journal of Physics: Conference Series. Vol. 119. 2008. 10 p.

9. Drohan J., Couchman J., Konstantinidis N. and other. The ATLANTIS visualization program for the ATLAS experiment // In Proc. of Computing in High Energy Physics (CHEP’04). 2004. pp. 361–364.

10. CERN. ROOT. An Object-Oriented Data Analysis Framework. 2013. URL: http://root.cern.ch/download/doc/ROOTUsersGuideA4.pdf

11. Al-Turany M., Bertini D., Karabowicz R. and other. The FairRoot framework // Journal of Physics: Conference Series. Vol. 396, Part 2. 2012. 10 p.

12. CERN. GEANT – Detector Description and Simulation Tool. 1994. URL: http://wwwasdoc.web.cern.ch/wwwasdoc/pdfdir/geant.pdf

13. UrQMD Collaboration. The UrQMD user guide. 2009. URL: http://urqmd.org/documentation/urqmd-3.3p2.pdf

14. Gudima K. K., Mashnik S. G., Sierk A. J. User manual for the code LAQGSM. Los Alamos National Laboratory, 2001.

15. Tadel M. Overview of EVE – the Event Visualization Environment of ROOT // Journal of Physics: Conference Series. Vol. 219. 2010. 10 p.

16. Fass`o A., Ferrari A., Roesler S. and other. The FLUKA code: Present applications and future developments // Computing in High Energy and Nuclear Physics 2003 Conference (CHEP2003). 2003.

17. OpenMP Architecture Review Board. OpenMP API. Version 4.0. 2013. URL: http://www.openmp.org/mp-documents/OpenMP4.0.0.pdf

18. Гладцын В. А., Яновский В. В. Средства моделирования вычислительных сетей. СПб.: Изд-во СПбГЭТУ "ЛЭТИ", 2001. 128 с.

19. Герценбергер К. В., Чепин Е. В. Аналитическая модель оценки производительности многопроцессорной обработки данных для набора параллельных алгоритмических структур // Бизнес-информатика : междисциплинарный научно- практический журнал. 2011. № 4 (18). С. 24–30.

20. Герценбергер К. В., Чепин Е. В. Использование параллельных алгоритмических структур для автоматизации процесса разработки параллельного программного обеспечения // Труды 53-й научной конференции МФТИ «Современные проблемы фундаментальных и прикладных наук». М.: МФТИ, 2010. С. 54–55.

21. Abseira Ltd. AIDA64 Business Edition. Manual. 2013. 82 p. URL: http://www.aida64.com/files/AIDA64BusinessEditionManual.pdf

EVENT VISUALIZATION OF THE MPD EXPERIMENT AT

THE NICA COLLIDER FOR THE MONITORING SYSTEM

K. Gertsenberger1, S. Merz1, E. Chepin2

1 Joint Institute for Nuclear Research, Dubna, Russian Federation

2 National Research Nuclear University MEPhI (Moscow Engineering Physics Institute), Moscow, Russian Federation

gertsen@jinr.ru, sergey.merts@gmail.com, chepin@dozen.mephi.ru

Abstract

One of the problems to be solved in high energy physics experiments on particle collisions (or fixed target experiments) is online visual presentation of the events during the experiment run. The article describes the implementation of this task for the future experiment MPD (Multi-Purpose Detector) at the NICA (Nuclotron-based Ion Collider fAcility) collider under construction at the Joint Institute for Nuclear Research in Dubna. The aims of the NICA complex are discussed briefly, as well as the structure of the multipurpose detector (MPD) for the study of hot and dense baryonic matter in collisions of heavy ions in the atomic mass range A=1–197 at a centre-of-mass energy up to 11 GeV (for Au79+). The developed approach implementing fast point reconstruction of primary and secondary particle tracks in collisions of heavy ions in the MPD detector is presented. In particular the article considers parallelizing the most time-consuming function – hit reconstruction of the TPC (time projection chamber) read-out pads, to accelerate the event visualization and consequently to increase the number of the events viewed in the monitoring system per second. The processing time values and speed-up coefficients are given for average and low multiplicities of the simulated data. The analytical modeling for execution of the parallel point reconstruction of particle tracks for a larger number of processors was used, the structure of parallel hardware platform for selective event monitoring is proposed. The implemented visualization system of the MPD geometry and collision events in the multipurpose detector, which is a part of the MPDRoot software being developed for the experiment, is considered. The example of graphical representation of the MPD geometry and reconstructed points of tracks is given for a central Au-Au collision.

Key words: physics data processing, clustering, visualization, monitoring, multithreaded application, analytical model, MPD.

References

1. Blaizot J. The Quark-Gluon Plasma from SPS to RHIC to LHC. QNP–2012. Available at: http://qnp2012.sciencesconf.org/conference/qnp2012/Blaizot.pdf

2. MPD Collaboration. The MultiPurpose Detector – MPD. Conceptual Design Report. JINR. 2012, p. 259.

3. M.N. Strikhanov, N.N. Degtyarenko, V.V. Pilyugin, E.E. Malikova, M.N. Matveeva, V.D. Adzhiev, A.A. Pasko. Computer visualization of nanostructures experience at NRNU "MEPhI", Scientific Visualization, vol. 1, № 1, 2009, pp. 1–18. Available at: http://sv-journal.com/2009-1/01.php?lang=en

4. CERN. Compact Muon Solenoid experiment at CERN’s LHC. Available at: http://cms.web.cern.ch

5. CERN. A Large Ion Collider Experiment. Available at: http://aliceinfo.cern.ch/Public/Welcome.html

6. CERN. ATLAS experiment. Available at: http://atlas.ch

7. Osborne1 I., Alverson G., Eulisse G. and other. CMS Event Display and Data Quality Monitoring at LHC Start-up. Journal of Physics: Conference Series. vol. 119, p. 7, 2008.

8. Tadel M. Raw-data display and visual reconstruction validation in ALICE. Journal of Physics: Conference Series. vol. 119, 2008, p. 10.

9. Drohan J., Couchman J., Konstantinidis N. and other. The ATLANTIS visualization program for the ATLAS experiment. In Proc. of Computing in High Energy Physics (CHEP’04), 2004, pp. 361–364.

10. CERN. ROOT. An Object-Oriented Data Analysis Framework. 2013. Available at: http://root.cern.ch/download/doc/ROOTUsersGuideA4.pdf

11. Al-Turany M., Bertini D., Karabowicz R. and other. The FairRoot framework. Journal of Physics: Conference Series, vol. 396, part 2. 2012, p. 10.

12. CERN. GEANT – Detector Description and Simulation Tool. 1994. Available at: http://wwwasdoc.web.cern.ch/wwwasdoc/pdfdir/geant.pdf

13. UrQMD Collaboration. The UrQMD user guide. 2009. Available at: http://urqmd.org/documentation/urqmd-3.3p2.pdf

14. Gudima K. K., Mashnik S. G., Sierk A. J. User manual for the code LAQGSM. Los Alamos National Laboratory, 2001.

15. Tadel M. Overview of EVE – the Event Visualization Environment of ROOT. Journal of Physics: Conference Series, vol. 219, 2010, p. 10.

16. Fass`o A., Ferrari A., Roesler S. and other. The FLUKA code: Present applications and future developments. Computing in High Energy and Nuclear Physics 2003 Conference (CHEP2003), 2003.

17. OpenMP Architecture Review Board. OpenMP API. Version 4.0. 2013. Available at: http://www.openmp.org/mp-documents/OpenMP4.0.0.pdf

18. Gladtsyn V. A., Yanovskiy V. V. Sredstva modelirovaniya vychislitelnykh setey [Modeling tools for computing networks]. Saint-Petersburg. SPbGETU "LETI", 2001, p. 128.

19. Gertsenberger K. V., Chepin E. V. Analiticheskaya model otsenki proizvoditelnosti mnogoprotsessornoy obrabotki dannykh dlya nabora parallelnykh algoritmicheskikh struktur [Analytical model for evaluating perfomance of multiprocessing for a set of parallel algorithmic structures]. Business informatics, vol. 18, № 4, 2011, pp. 24–30.

20. Gertsenberger K. V., Chepin E. V. Ispolzovanie parallelnykh algoritmicheskikh struktur dlya avtomatizatsii protsessa razrabotki parallelnogo programmnogo obespecheniya [The use of parallel algorithmic structures for automation of development process of parallel software]. Proceedings of 53 scientific conference MFTI «Modern problems of fundamental and applied sciences». Moscow, MFTI, 2010. pp. 54–55.

21. Abseira Ltd. AIDA64 Business Edition. Manual. 2013. p. 82. Available at: http://www.aida64.com/files/AIDA64BusinessEditionManual.pdf